Kürzlich berichteten viele Medien über ein Bild, das eine Explosion beim Pentagon in Washington zeigen sollte. War es ein echtes Foto? Schnell wurde vermutet, es handle sich dabei um ein mit generativer KI produziertes Bild. Und ebenso schnell wurde daraus der Schluss gezogen, KI-Bilder seien gefährlich und würden Lügen verbreiten. Doc Baumann fragt sich, ob das wirklich stimmt.

Ein Brandanschlag auf das Weiße Haus in Washington? Das „Foto“ ist genauso echt wie das der angeblichen Eplosion vor dem Pentagon. (Montage: Doc Baumann)

Sind Bilder, die mit generativer KI erzeugt wurden, gefährlich? Die Antwort ist einfach: Ja, das können sie sein, indem sie zum Beispiel zu falschen Annahmen über die Realität verleiten. Wenn es sich nicht gerade um ein scherzhaftes Experiment handelt (wie im Falle der „Fotos“ von der Trump-Verhaftung), ist das ja schließlich in solchen Fällen auch ihre hinterhältige Aufgabe. Die Sache mit den Lügen spare ich mir für einen ausführlichen Beitrag auf, den Sie in DOCMA 108 lesen können. Mein Kollege Michael J. Hußmann war in seinem Blog-Beitrag „KI: Lügende Texte, lügende Bilder“ ja vor einiger Zeit bereits auf dieses Thema eingegangen.

Ebenso wie die meisten Digitalmontagen sind jedoch die allermeisten KI-Bilder natürlich nicht gefährlich. Auch dann nicht, wenn sie eine Welt zeigen, die mit unserer kaum etwas zu tun haben. Denn die zahllosen Elfen, langbärtigen Magier, Einhörner, Kätzchen und Phantasielandschaften führen niemanden in die Irre. Wer sie sieht weiß: Unrealistisch – aber das soll auch gar nicht meine Wirklichkeit widerspiegeln, sondern die von Mittelerde, Scheibenwelt oder sonstwo.

Ist dieses stillschweigende Einverständnis zwischen Bildproduzenten und Betrachtern allerdings nicht gegeben, kann es problematisch werden. Vor allem dann, wenn der Präsentationskontext nach eingeübten Erwartungen vermuten lässt, dass wir eine authentische Abbildung sehen, das Bild einer Szene, die es ungestellt in unserer Wirklichkeit tatsächlich gegeben hat. Zudem erwarten wir aufgrund dieses Kontextes, dass das Bild zeitlich und räumlich korrekt zugeordnet wird. Das Foto eines erschossenen Menschen oder eines bei einem Erdbeben zusammengestürzten Hauses mit verzweifelten Menschen davor kann ein echtes und unverfälschtes Foto sein – aber aufgenommen an einem ganz anderen Ort und lange vor dem aktuellen Ereignis, das es vorgeblich wiedergibt.

Insofern ist die Behauptung, Bilder könnten gefährlich sein und für Manipulationszwecke eingesetzt werden, völlig richtig. Falsch ist lediglich die in den zahllosen Kommentaren verbreitete Annahme, KI-Bilder seien besonders gefährlich. Dieser Schluss wurde jedenfalls oft nahegelegt.

Eine Explosion vor dem Pentagon in Washington? KI-Bild sicherlich … aber Pentagon?

Und warum steht der Zaun noch?

Bilder werden für Propaganda- und Manipulationszwecke eingesetzt, seit es sie gibt. Ob sich römische Herrscher mit athletischen Prachtkörpern repräsentieren ließen, die Kirche Teufel und Dämonen an die Wände ihrer Gotteshäuser malen ließ, um die Gläubigen in Angst und Schrecken zu halten, ob Reformationsflugblätter den Papst als Monster darstellten oder Diktatoren Fotos – noch mit Pinselchen und Retuschierfarbe – verfälschen ließen … der Zweck der zielgerichteten Irreführung war immer derselbe.

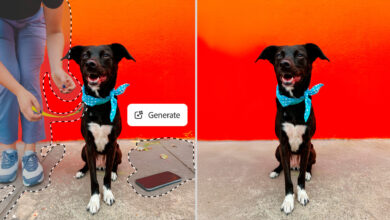

Wir kennen Bildmanipulationen heute vorwiegend mit den digitalen Werkzeugen und Verfahren von Photoshop & Co. Auch hier gilt dasselbe wie oben beschrieben: Die meisten dieser Eingriffe sind harmlos, auch dann, wenn sie Betrachter dazu verleiten, die Existenz einer anderen Szene anzunehmen, als sie tatsächlich aufgenommen wurde. Viele Retuschen entfernen lediglich störende Elemente oder sind Spielereien ohne Täuschungsabsicht. Oder sie erscheinen in einem fiktionalen Umfeld oder dem der Werbung (was ungefähr dasselbe ist).

Der einzige Unterschied zu KI-Bildern besteht darin, dass diese sehr viel einfacher und schneller herzustellen sind. Dagegen spielt es keine Rolle, dass sie weniger perfekt sind und Mängel aufweisen. Erstens, weil das nur eine Feststellung bezüglich des aktuellen Entwicklungsstandes ist und mit guten Gründen erwartet werden kann, dass das wohl schon in wenigen Monaten anders aussehen und zunehmend perfektioniert werden wird. Und zweitens, weil bekanntlich menschliche Bildbearbeiter nicht unbedingt weniger Fehler machen. (Sonst würde es meine Beiträge zur Bildkritik schon lange nicht mehr geben.)

Wollte man etwa die Szenen der Trump-Verhaftung oder des Papstes im weißen Daunen-Parka per Photoshop nachstellen, müsste man auf echte Fotos zugreifen. Das hätte nicht nur eventuell Urheberrechtsprobleme zur Folge, sondern die Ausgangsbilder ließen sich bei Recherchen auffinden. Es würde also mehr Aufwand, Mühe und Kompetenz erfordern, solche Ergebnisse glaubhaft herzustellen. Aber man darf nicht vergessen, dass das bis zum Einsatz von KI (also vor sehr kurzer Zeit) noch die Norm war. Vor ein, zwei Jahren hätte sich niemand über den nötigen Arbeitsaufwand für eine solche Montage beschwert, es ging ja nicht anders. So, wie niemand zur Zeit der Postkutsche beklagt hätte, dass er nicht in ein paar Stunden von München an die Nordsee kommt (die allgegenwärtigen Bahnverspätungen mal außen vor gelassen) oder gar nach New York.

Vielleicht finden wir es in ein paar Jahren amüsant altmodisch, Bilder zu erzeugen, indem wir aufwendige Prompts formulieren und per Tastatur eingeben müssen, die eine KI versteht, wo man sie sich doch einfach in seinen Gedanken vorstellen und in Sekundenschnelle umsetzen lassen kann.

Fazit also: Manipulative Bilder, die per KI hergestellt wurden, sind in ihrer Wirkung nicht gefährlicher – oder ungefährlicher – als solche, die dank digitaler Bildbearbeitung zustande gekommen sind. (Und wer besonders naturalistisch malen kann, könnte auch ein solches Gemälde verkleinert reproduziert als korrekte Wiedergabe der dargestellten Szene ausgeben.) Sie lassen sich lediglich schneller, oft besser und mit geringeren Anforderungen an die Kompetenz der Produzenten herstellen.

Das konkrete Bild der angeblichen Explosion vor dem Pentagon ist bereits mit geringer Erfahrung an zahlreichen Stellen als KI-Produkt zu erkennen; ganz davon abgesehen, dass es wohl kaum das Pentagon zeigt, das von keiner Seite so aussieht.

Ohne Zugriff auf Stockfotos (mit Ausnahme des Weißen Hauses; Pexels, Thuan Vo) habe ich mal schnell mit Material aus meinem eigenen Bildarchiv diese Explosion vor dem Sitz der US-Präsidenten montiert: die Rauchsäule einer Dampflokomotive, bewölkter Himmel, aus dem Flugzeug fotografierte Wolken von oben, der brennende Bibliotheksturm bei den Dreharbeiten zu „Der Name der Rose“ (aus meinem Buch zum Film von 1986), ein Osterfeuer sowie Schutt auf einer Baustelle. Und schon hätten wir, ganz ohne KI, einen Anschlag aufs Weiße Haus.

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft: Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.