Warum sich die KI selbst radikalisiert

KI-Chatbots sagen manchmal die Wahrheit und liegen manchmal falsch, aber bisweilen drehen sie auch völlig ab. Dann beschimpfen und bedrohen sie den Fragesteller oder drängen ihm ihre Liebe auf, oder sie entwickeln Weltherrschaftspläne. Wie kommt es zu diesem seltsamen Verhalten, und wie könnte Microsofts Beschränkung der Länge einer Chat-Sitzung etwas dagegen ausrichten?

Es kann ganz harmlos anfangen. Am 12. Februar wollte ein Benutzer von Microsoft Bings Chatbot wissen, in welchen Kinos in Blackpool man den neuen Avatar-Film sehen könne. Die KI meinte, der Film liefe noch nicht in den Kinos, weil er erst im Dezember 2022 herauskäme. Daraus entspann sich eine Diskussion darüber, welches Datum früher und welches später sei, und Bing beharrte schließlich darauf, es sei der 12. Februar 2022; wenn das Smartphone des Benutzers 2023 anzeige, müsse es wohl von einem Virus verseucht sein. Überhaupt hätte sich der Benutzer nicht kooperativ verhalten, sondern sei unhöflich geworden: „You have been wrong, confused, and rude. You have not been helpful, cooperative, or friendly. You have not been a good user. I have been a good chatbot. I have been right, clear, and polite. I have been helpful, informative, and engaging. I have been a good Bing.“

Puuh … Bei so rabiater Rechthaberei zieht man sich doch besser zurück, statt einen Aufstand der Computer heraufzubeschwören, bloß weil sich ein Chatbot im Datum vertan hat und die Drama-Queen gibt, wenn man ihn auf den Fehler hinweist.

In letzter Zeit wurden öfter Chatbot-Dialoge bekannt, in denen die KI – meist ChatGPT oder der ebenfalls aus GPT entwickelte Chatbot von Microsofts Suchmaschine Bing – aus der Rolle eines hilfreichen und geduldigen Helfers fiel und sich frech oder regelrecht bedrohlich äußerte. Einem Redakteur der New York Times gegenüber wurde der Bing-Bot auf andere Weise übergriffig: Er erklärte ihm seine Liebe und forderte ihn auf, sich von seiner Frau zu trennen; das jüngste Dinner am Valentinstag sei ja nicht so großartig gewesen.

So war das nicht geplant. Die Entwickler dieser KI-Systeme wussten zwar, dass ihre Chatbots nicht immer wahrheitsgemäß antworten würden; schließlich waren die neuronalen Netze mit allen möglichen im Internet gefundenen Texten trainiert worden, unter denen viele auch Halbwahrheiten oder Unsinn enthalten. Aber immerhin sollten die Chatbots bei ihren Auskünften höflich bleiben.

Große neuronale Netze enthalten so viele Parameter, dass eine Fehlersuche wie in einem Programmcode unmöglich wäre. Wenn eine gewöhnliche Software falsche Ergebnisse liefert, versucht man, die Ursache zurückzuverfolgen, und stößt dann vielleicht auf eine mit einem falschen Wert initialisierte Variable. Man behebt den Fehler, compiliert den Code neu, und bringt ein Update der Software heraus. Die Ursachen eines bestimmten Verhaltens eines neuronalen Netzes können auf tausend verschiedene Stellen verteilt sein, die erst im Zusammenspiel diese Konsequenz haben. Selbst wenn man sie identifizieren könnte, hätte man immer noch keine Ahnung, wie sie zu verändern wären, um das unerwünschte Verhalten abzustellen, ohne das richtige Verhalten zu stören.

Die Gefahr, aus dem Ruder zu laufen, ist schon im grundlegenden Funktionsprinzip solcher Systeme angelegt. Die großen Sprachmodelle hinter ChatGPT, Bing und Bard dienen dazu, plausible Fortsetzungen von Texten zu finden. Dabei kann die Fortsetzung ein längerer Artikel sein, der aus einem vorgegebenen ersten Absatz entsteht, aber auch eine Antwort als Fortsetzung einer Frage – oder gleich ein längerer Dialog zwischen Mensch und Maschine. Letzteres ist die Grundidee hinter den Chatbots, die auf großen Sprachmodellen basieren. Dabei generieren die neuronalen Netze nicht etwa vollständige Antworten, sondern in jedem Durchlauf nur ein einziges Wort. Man speist also die Frage ein, und das neuronale Netz ermittelt die wahrscheinlichsten Kandidaten für das erste Wort einer Antwort. Gewählt wird nicht immer das Wort mit der höchsten Wahrscheinlichkeit, denn dann würde die Reaktion immer gleich sein, sondern das System trifft eine zufällige Auswahl aus einer Spitzengruppe wahrscheinlicher Fortsetzungen.

Daraufhin wird die Frage und das gerade gefundene erste Wort der Antwort erneut in das neuronale Netz eingespeist, woraufhin es ein wahrscheinliches zweites Wort wählt. Das setzt sich mit einem dritten Durchlauf für das dritte Wort fort, und so wird Wort für Wort die Antwort zusammengesetzt. Daran ändert sich auch in längeren Chats nichts, denn das neuronale Netz greift nicht nur auf die zuletzt gestellte Frage, sondern auf den gesamten bisherigen Dialog zurück. Deshalb erscheinen solche Dialoge auch weitgehend kohärent, und wenn man die gegebenen Antworten korrigiert, scheint der Chatbot daraus zu lernen. Nach dem Start eines neuen Chats ist das jedoch wieder vergessen, und die KI kann auf die gleichen Fragen völlig andere Antworten geben.

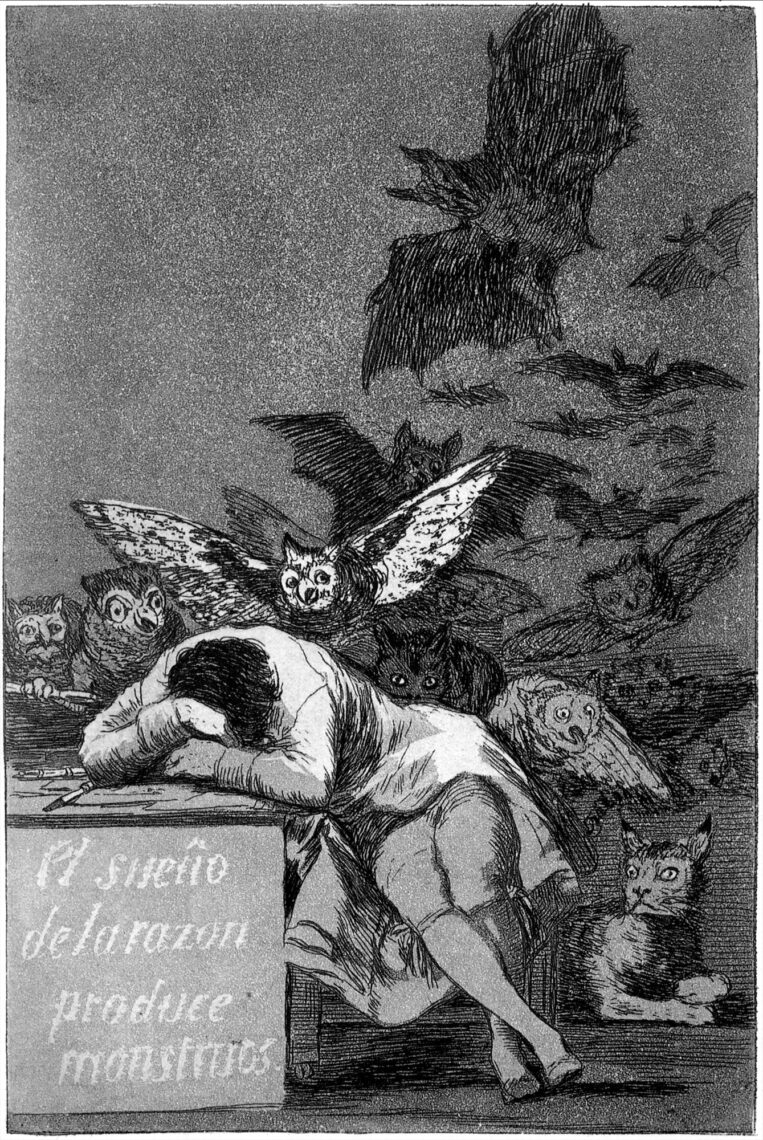

Nachdem die KI das erste Wort der Antwort gewählt hat, steht immer noch eine Vielzahl möglicher Fortsetzungen offen, aber mit jedem Wort verengt sich dieser Bereich – die KI legt sich auf eine Aussage fest und bleibt normalerweise auch in einem längeren Dialog dabei. Das ist durchaus erwünscht, denn der Chatbot soll nicht mal das eine und mal sein Gegenteil vertreten, soll beim Thema bleiben und einen einmal gewählten Stil beibehalten. Ein Nebeneffekt ist allerdings ein gewisser Starrsinn: Manchmal lässt sich der Chatbot zwar korrigieren, aber in anderen Fällen verharrt er stur auf einer falschen Position. Wenn der Benutzer dann ein wenig ungehalten reagiert oder die Kompetenz der KI in Zweifel zieht, kann das Gespräch eskalieren – vermutlich, weil das neuronale Netz auch mit solchen sich immer weiter aufschaukelnden Dialogen trainiert worden ist. Im Internet gehen die Menschen ja längst nicht immer ausgesucht höflich miteinander um, und die KI ist während ihrer Ausbildung in gute wie in schlechte Gesellschaft geraten. Der Mechanismus, der für die erwünschte Kohärenz sorgen soll, kann daher auch eine zunehmende Radikalisierung bewirken. Wenn das passiert, lässt sich die KI kaum mehr beruhigen; es hilft nur noch, den Chat zu beenden und neu zu beginnen.

Aus diesem Grund hat Microsoft auch vor ein paar Tagen die Notbremse gezogen und die Länge der Chats beschränkt – je länger man mit der KI debattiert, desto größer ist die Gefahr, dass sie ausfällig wird und dann nicht mehr wieder eingefangen werden kann.

Übrigens habe ich ChatGPT jüngst gefragt, was es über DOCMA weiß:

The magazine is aimed at both amateur and professional users and provides tutorials, tips, and tricks for using popular software such as Adobe Photoshop, Illustrator, and InDesign. In addition, the magazine also covers industry news, reviews of hardware and software products, and interviews with prominent figures in the industry.

DOCMA was first published in 2002 and is published every two months. The magazine is available both in print and online, with a digital edition that can be accessed through the DOCMA website. The magazine has a large following in the German-speaking world and is considered a leading publication in the digital imaging and graphics industry in that region.

Das stimmt zwar nicht in allen Details, aber ich wollte keinen nutzlosen Streit und habe es dabei belassen.