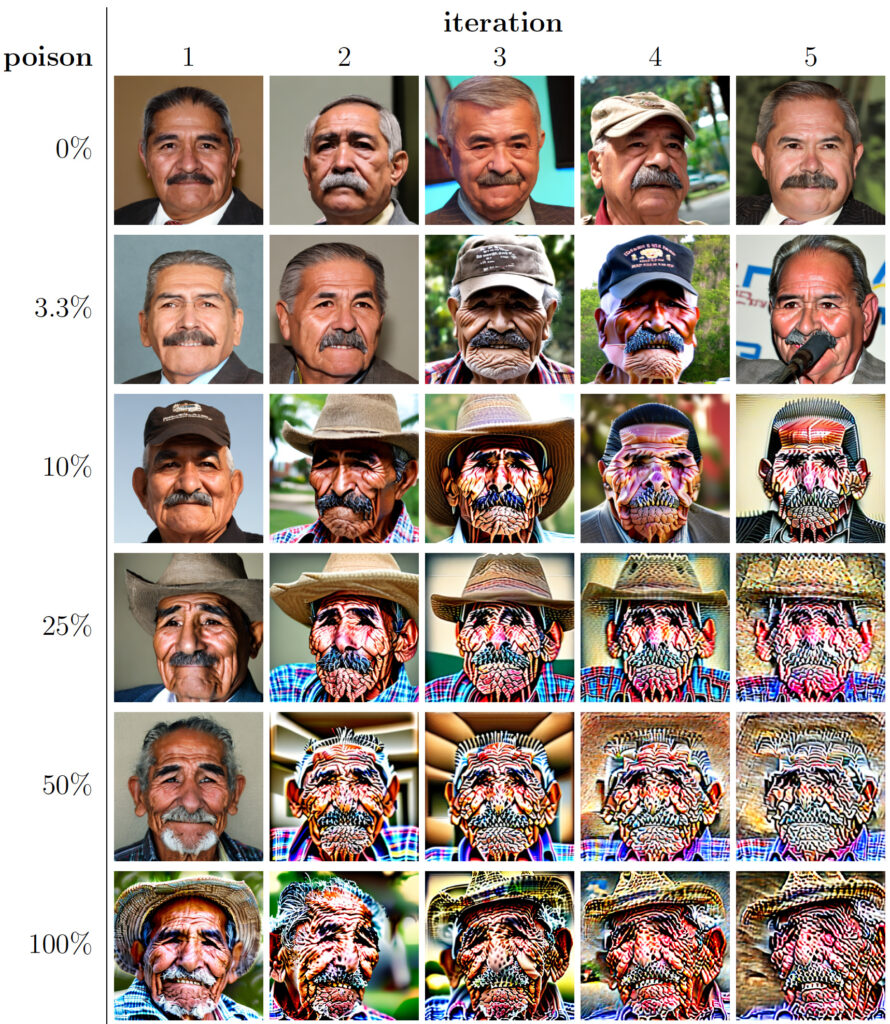

Wie an dieser Stelle bereits gemeldet, kollabieren die unterschiedlichsten Arten von KI-Modellen, wenn sie mit Input trainiert werden, den sie selbst produziert haben. Aber warum vergiften sich KI-Systeme mit ihren eigenen Erzeugnissen?

Dass KI-Systeme für ihre Weiterentwicklung immer wieder frischen, von Menschen produzierten Input brauchen, wenn sie nicht degenerieren sollen, ist schon länger bekannt. Der aktuelle Artikel zeigt nur, wie universell das Problem ist, denn es betrifft textbasierte Systeme wie ChatGPT ebenso wie neuronale Netze mit ganz anderer Architektur, die Bilder generieren.

Wir kennen das Problem aus Vampirfilmen: Vampire beißen Nicht-Vampire, saugen ihr Blut und machen ihre Opfer damit ebenfalls zu Vampiren. Gäbe es nicht die van Helsings, die sie bekämpfen, wäre bald die gesamte Menschheit untot – aber was dann? Wovon wollten die Untoten sich ernähren, wenn es keine Lebenden mehr gäbe? Sind es also nicht eigentlich die Vampirjäger, die das Überleben der Vampire sichern, gerade indem sie deren Siegeszug verhindern? Die Hersteller von KI-Systemen haben ein ähnliches Problem: Sie haben bereits fast das gesamte Internet zur Gewinnung von Trainingsmaterial abgegrast und brauchen neuen Input, um ihre Systeme weiter zu verbessern, aber was an Bildern und Texten neu gepostet wird, sind immer öfter bereits KI-Produkte. Oft werden die KI-Modelle daher mit ihrem eigenen Output als Input gefüttert.

Wer sich weiterentwickeln will, braucht Herausforderungen, und wer nur mit seinen eigenen Hervorbringungen gefüttert wird, muss zwangsläufig stagnieren. Eine generative KI wird sich nicht am eigenen Haarschopf aus dem Sumpf ziehen und etwas Neues erfinden, sondern sich in einen immer engeren Korridor des aktuellen Mainstream einordnen. Dass eine mit KI-Bildern trainierte KI immer langweiligere Resultate produzieren wird, liegt auf der Hand, aber warum generiert sie stattdessen zunehmend abstruse Ergebnisse?

Das Training einer KI mit vorgefundenen Beispielen hat generell die Eigenheit, wahrscheinliche Ergebnisse zu verstärken und weniger wahrscheinliche (aber mögliche) Ergebnisse abzuschwächen. Nun entwickelt jede KI bestimmte Eigenheiten, einen Stil, wenn man so will, die normalerweise unter unserer der Wahrnehmungsschwelle bleiben – wir achten eben auf andere Dinge. Werden Bilder oder Texte mit solchen Eigenheiten aber im Training der nächsten KI-Generation als Lehrstoff rückgekoppelt, werden sie verstärkt, da sie ja nun in jedem Beispiel vorkommen und folglich als sehr wahrscheinlich gelten müssen. Eine KI, die die Idiosynkrasien ihrer Vorgängergeneration hervorhebt, wird im Training noch darin bestärkt, während ihre eigentliche Aufgabe zunehmend in den Hintergrund tritt. Schon nach wenigen Generationen pflegt die KI nur noch ihre eigenen Verschrobenheiten und ist für unsere Zwecke wertlos – sie ist kollabiert.

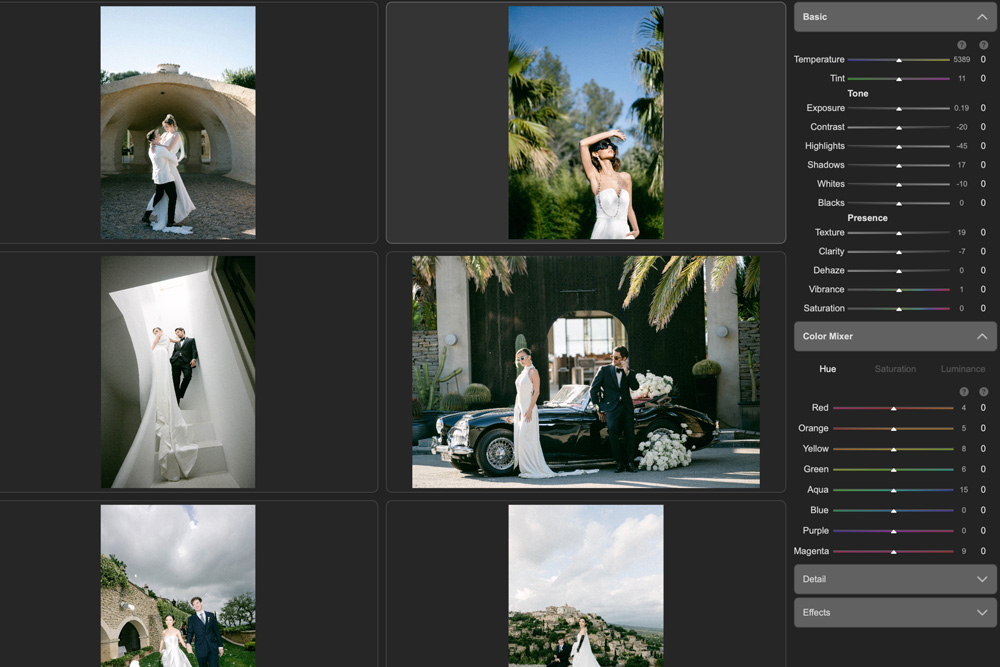

Selbst wenn man das Problem erkennt und im weiteren Training wieder menschengemachtes Trainingsmaterial einspeist, wird sich die KI nicht wieder vollständig erholen, wie man an den Beispielen oben sieht – teilweise wird die Qualität der von einer generativen KI erzeugten Bilder wieder besser, aber manche der erworbenen Merkwürdigkeiten halten sich hartnäckig.

Um eine solche Entwicklung zu verhindern, könnte man das Trainingsmaterial vorher sichten, aber das wäre ein aufwendiges Verfahren und angesichts der nötigen Größe eines Trainingskorpus kaum praktikabel. Daher wäre es auch im Interesse der Hersteller der KI-Systeme, deren Erzeugnisse als KI-generiert zu markieren, sei es über digital signierte Metadaten nach dem CAI/C2PA-Standard oder mit eingebetteten Wasserzeichen. Nur so könnten sie ihre KI-Modelle davor schützen, sich an ihrem eigenen Output zu vergiften.

Es besteht zwar die Hoffnung, dass die tödliche Selbstverstärkung unerwünschter Eigenheiten unterbliebe, wenn eine KI mit dem Material einer anderen KI mit anderen Idiosynkrasien trainiert würde. Möglicherweise würde der Kollaps damit aber auch nur herausgeschoben, da sich die KI-Modelle verschiedener Hersteller dadurch immer weiter anglichen – am Ende hilft doch nur „frisches Blut“, um den Vampirvergleich wiederaufzunehmen.

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft:

Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Das DOCMA-Magazin können Sie als Print-Ausgabe und als E-Paper kaufen oder abonnieren. Alternativ bieten wir die Inhalte der jeweils aktuellsten DOCMA-Ausgabe auch im Abo in Form der DOCMA2go als wöchentliche E-Mails an (verteilt über 13 Wochen).

Zu den Print-Abos | Zu den Digital-Abos

Das HAuptproblem dürfte eben darin zu sehen sein, daß die „KI“ EBEN NICHT!! „intelligent“ IST! Die „KI“ ist eben nicht in der Lage, selber zu erkennen, daß jedes der obigen Portraits von denen weiter rechts eben NICHT einem natürlichen Menschenkopf entspricht. Natürlich nur, wenn nicht ausdrücklich ein „Monster“ oder ein surreales Bild entstehen sollte. Die „KI“s haben alle keinerlei Allgemeinwissen. Nicht das mindeste. Deswegen scheitern sie, mit 6 Fingern, 3 Beinen, nur einem Bein und das andere losgelöst irgendwo anders im Bild usw usw usw usw usw. Sie sind alle nur dumm.

Wenn ich eine „KI“ programmieren sollte, die man auch – und gerade! – für legale Zwecke einsetzen mag, dann Sorge ich doch verdammt nochmal dafür, daß die Anatomie zu ihrem Recht kommt. Menschen haben nun mal nur 5 Finger pro Hand (OKOK, mit gaaanz wenigen Ausnahmen, Marilyn Monroe z.B. raunt man unbewiesen sowas nach…), 2 Beine und das alles an GANZ bestimmten, seit Jahrmilliarden vorgesehenen Positionen am Körper. Punkt. Eine „KI“ ohne Tüttelchen MUß! das wissen und praktizieren = man muß es ihr erstmal beibringen. Aber das ist SEHR viel Arbeit, deswegen unterbleibt es stets. Deswegen dann dieser absolute Bullshit, den manche Progs in die Welt kotzen. Immer unter der Annahme, es SOLL ein natürliches Aussehen produziert werden. Dann muß man des Proggies aber klar und klipp sagen, wie natürlich „natürlich“ aussehen muß. Als „Kunst“ geht alles durch und wenn es NOCH so gräuslig und erbärmlich ist.

Bis man bei „KI“ die Tüttelchen getrost weglassen kann, wird noch Zeit vergehen…