Unsere Augen im All mit Hayabusa 2

Wenn es um die aufregendsten Kameras geht, dann sind das für mich nicht die Modelle, mit denen ich tatsächlich fotografiere. Es sind nicht einmal die Kameras, die ich gerne hätte, mir aber nicht leisten kann. Es sind vielmehr jene, von ihren technischen Daten her gar nicht so spektakulären Kameras, mit denen Raumsonden wie Hayabusa 2 Bilder aus allen Ecken des Sonnensystems zur Erde schicken.

Vor dreieinhalb Jahre startete die Sonde Hayabusa 2 („Wanderfalke 2“) der japanischen Raumfahrtagentur JAXA. Mit ihrem Ionenantrieb steuerte sie Ryugu an, einen Asteroiden des Apollo-Typs, der sich nicht im Asteroidengürtel zwischen Mars und Jupiter, sondern nahe der Erdbahn aufhält. Vor wenigen Tagen ist sie dort angekommen und hat die ersten Bilder übermittelt. Hayabusa 2 wird in den nächsten Monaten ein umfangreiches Forschungsprogramm absolvieren und unter anderem die deutsch-französische Landeeinheit MASCOT auf der Oberfläche absetzen. Nachdem Hayabusa 2 Material des Asteroiden eingesammelt hat, wird sie damit in zwei Jahren zur Erde zurückkehren.

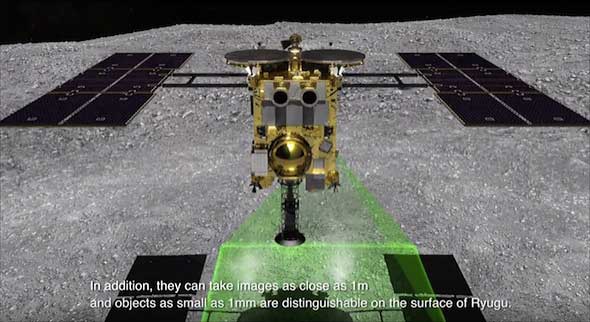

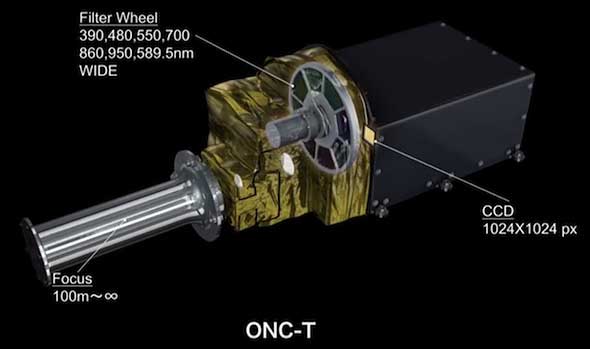

Hayabusa 2 ist mit mehreren Kameras für unterschiedliche Aufgaben ausgestattet, und die Landeeinheiten wie MASCOT besitzen jeweils eigene Kameras. Ein typisches Beispiel ist die „Optical Navigation Camera T“ (ONC-T) von Hayabusa 2, die mit einem Teleobjektiv ausgestattet ist. Je nach Abstand zum Asteroiden wird sie Details von bis zu 1 mm auflösen. Der Sensor ist ein CCD mit einer Auflösung von einem Megapixel (1024 × 1024 Pixel) – hier auf der Erde wäre das nichts, mit dem man angeben könnte, aber für den Einsatz in Raumfahrtmissionen setzt man auf eine robuste und bewährte Technik. Man kann sich keine Überraschungen mit Kinderkrankheiten einer brandneuen Technologie leisten, die sich erst offenbaren, wenn die Raumsonde bereits Millionen von Kilometern von der Erde entfernt ist.

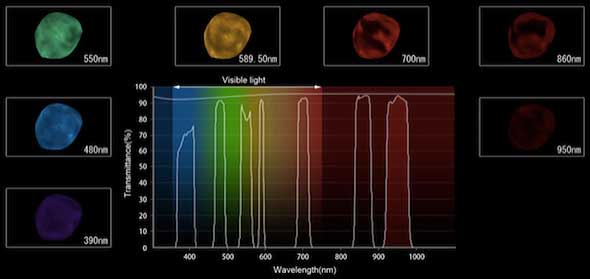

Anders als typische Bildsensoren in Digitalkameras hat das CCD in der ONC-T keine RGB-Farbfilter im Bayer-Muster. Stattdessen dreht sich ein Rad mit sieben Filtern im Strahlengang, die Licht in verschiedenen, scharf begrenzten Wellenlängenbereichen herausfiltern. Aus Aufnahmen in allen sieben Wellenlängenbereichen lassen sich Bilder in natürlichen Farben berechnen, aber die Farbauszüge dienen vor allen dazu, unterschiedliche chemische Elemente an der Oberfläche des Asteroiden zu identifizieren.

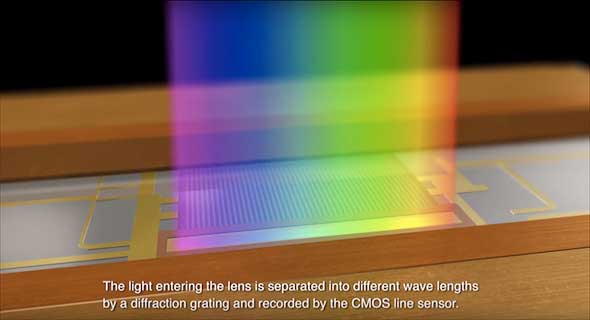

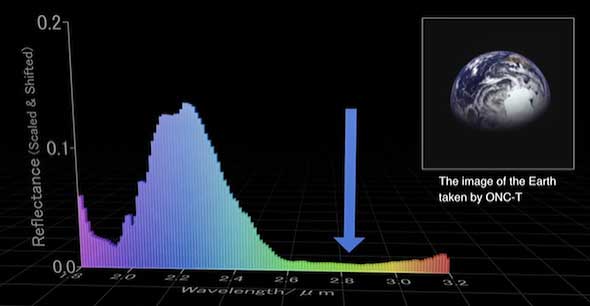

Eine ähnliche Aufgabe hat auch das Infrarot-Spektrometer NIRS 3, das Licht im Bereich des nahen Infrarot mit einem Beugungsgitter zu einem Spektrum auffächert, das dann von einer CCD-Zeile aufgefangen wird. Mit dieser Kamera wird es möglich sein, Vorkommen von Wasser zu identifizieren, und dass dies funktioniert, hat NIRS 3 unter Beweis gestellt, als Hayabusa 2, um Schwung zu holen, noch einmal an der Erde vorbeiflog: Das Wasser der Ozeane hat das Spektrometer korrekt erkannt.

Die Kameras von Raumsonden sind generell simpel aufgebaut und robust konstruiert, und eben deshalb machen sie auch praktisch nie Probleme. Vermeintliche Nachteile wie die geringe Sensorauflösung sind gegenstandslos, da sich ein Mosaik zahlreicher Aufnahmen mit unterschiedlichen Bildausschnitten zu einem hochaufgelösten Gesamtbild verrechnen lässt – man wendet gewissermaßen die Brenizer-Methode an, aus vielen Tele-Aufnahmen ein Weitwinkelbild zusammenzusetzen.

Raumsonden wie Hayabusa 2 dringen in Regionen unseres Sonnensystems vor, die noch „nie ein Mensch zuvor gesehen hat“, und ihre Kameras zeigen uns, wie es dort aussieht. Damit kann keine Canon, Fuji, Leica, Nikon, Olympus, Panasonic, Pentax oder Sony mithalten.