Superresolution oder warum die Impressionisten keine KI brauchten

Die KI-basierten Verfahren zum Hochskalieren von Bildern sind für mich eine der besten Erfindungen der letzten Jahre, und ich wüsste gar nicht mehr, was ich ohne sie täte. Nur: Wie weit soll und darf man dabei gehen? Und was hat das alles mit dem Impressionismus zu tun?

Kürzlich war ich mal wieder in der Hamburger Kunsthalle. Meine übliche Begleiterin (nicht nur) zu Kunstausstellungen hatte mich gefragt, ob die schon länger laufende und erneut verlängerte Ausstellung Impressionismus – deutsch-französische Begegnungen etwas tauge, und ich wollte noch mal nachschauen.

Genau genommen besteht die Impressionismus-Ausstellung in der Lichtwark-Galerie der Kunsthalle nur aus den bekannten, etwas anders gehängten und so neu zusammengestellten Werken der Sammlung; Neuentdeckungen findet man dort nicht. Aber als ich so durch die Säle schlenderte, fiel mir etwas auf – doch bevor ich dazu komme, muss ich zuerst etwas zu den KI-basierten Superresolution-Verfahren sagen.

Als Redakteur war ich schon früher regelmäßig in die Situation gekommen, dass ich für die Illustration von diesem oder jenem zwar ein passendes Bild fand, nur hatte das eine so geringe Auflösung, dass es für ein Magazin-Layout nicht in Frage kam. Bei Bildmaterial aus der Frühzeit der Digitalfotografie war das oft der Fall, und auch analoge Bilder waren oft nur mit einer geringen Auflösung gescannt worden. Auf einer Webseite mochte es noch angehen – zumindest vor der Erfindung der High-DPI-Bildschirme –, aber im Druck hätte man hässliche Pixeltreppchen gesehen. Mit Tricksereien wie mehrfachen Interpolationen in kleinen Schritten kam ich dann nicht viel weiter; etwas besser funktionierte die Skalierung mit fraktalen Algorithmen oder meinem damaligen Favoriten, dem CDC-4x-Verfahren von Binuscan. Aber erst die neuen KI-basierten Superresolution-Verfahren haben dieses Problem fast vollständig gelöst.

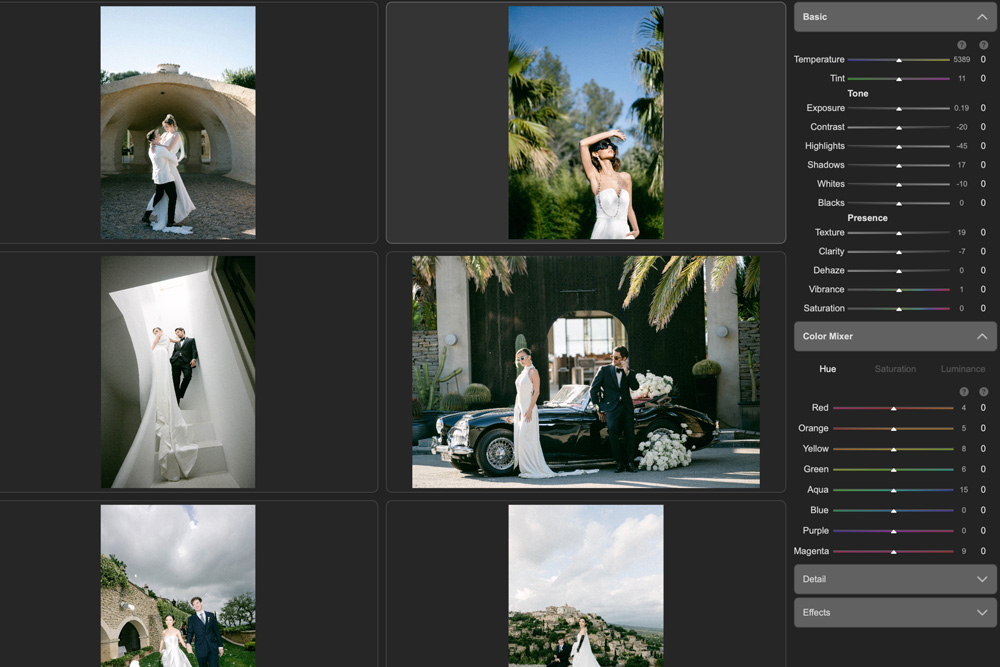

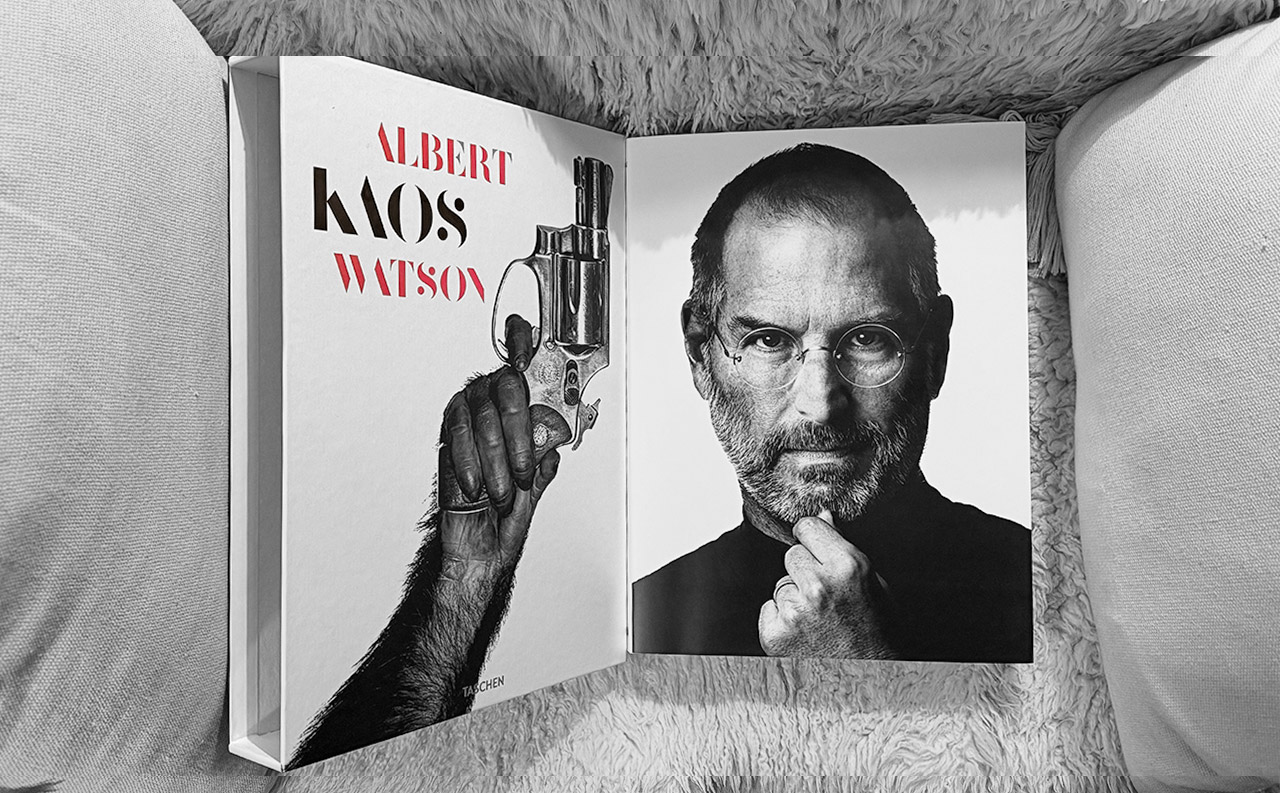

Für einen Artikel in DOCMA 105 („Schön … aber ist das auch Kunst?“) musste ich beispielsweise ein Bild vierfach vergrößern, was der Software von Topaz ein Leichtes war:

Bei solchen Anwendungen geht es wohlgemerkt nur darum, so viele Details passend zu ergänzen, dass sich ein Bild ohne sichtbare Pixel-Artefakte drucken lässt. Mit Skalierungsfaktoren zwischen 2× und 4× komme ich da immer aus, und mehr zu verlangen, würde die Phantasie der KI herausfordern – die Ergebnisse wären dann nicht mehr so schön.

Und damit komme ich zu den Impressionisten. In der Kunsthalle betrachtete ich ein Werk Alfred Sisleys, eines britischen Impressionisten, der seit seiner Geburt in Frankreich gelebt hatte. Sein Kornfeld bei Argenteuil von 1873 zeigt kleinteilige Landwirtschaft: ein schmales Weizenfeld rechts, dem das Bild seinen Titel verdankt, eine Wiese mit (möglicherweise) Apfelbäumen links, und ein weiteres schmales Feld in der Mitte. Was dort wächst, scheint auch den Kuratoren der Kunsthalle nicht recht klar zu sein; sie sprechen nur von „jungen Pflanzen“. Müsste ich raten, würde ich auf Kartoffeln tippen.

Aus einem normalen Betrachtungsabstand wirkt der vordere Teil des Feldes plastisch; man erkennt einzelne Pflanzen in hellbrauner Erde, deren Blätter im Sonnenlicht einen Schatten werfen. Erst weiter hinten verschwimmen die Blätter zu einem unstrukturiert grünen Teppich.

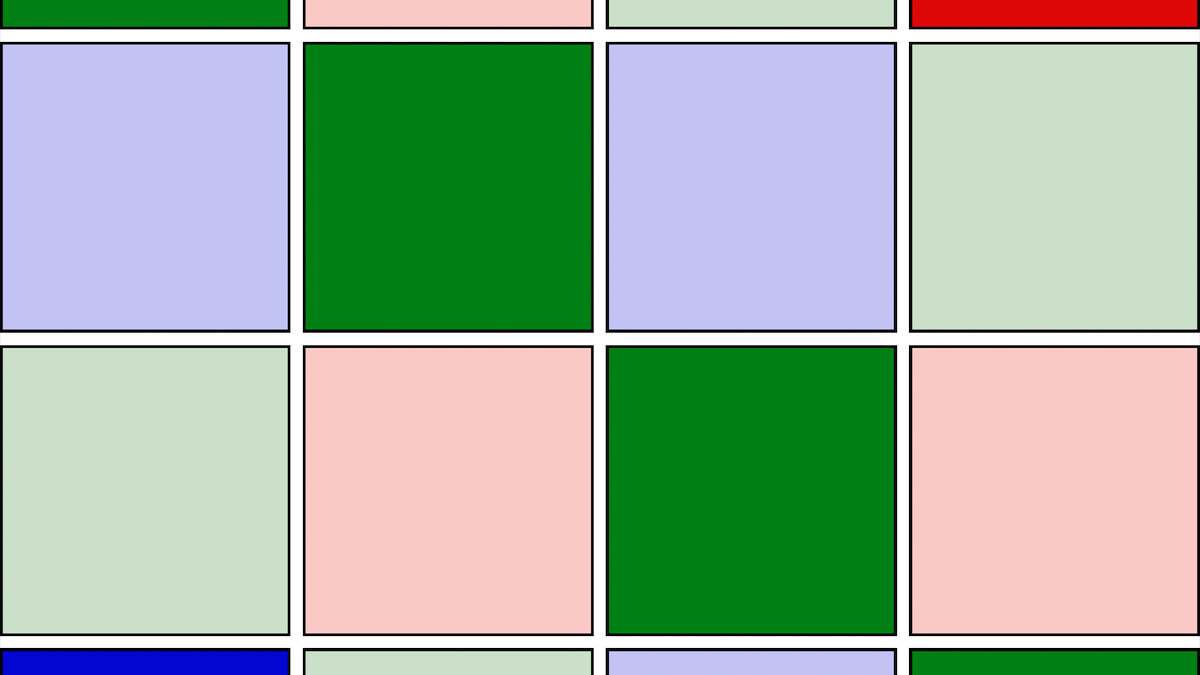

Als ich mir nun aber die Pflanzen genauer anschauen wollte und einen Schritt näher trat – dankenswerterweise wurde nicht gleich ein Alarm ausgelöst –, waren nicht etwa mehr Details zu erkennen. Vielmehr wandelte sich das Bild in ein abstraktes Muster einzelner Farbkleckse, die der Maler jeweils mit einem kurzen Pinselstrich aufgetragen hatte. Ich sah keine Pflanzen oder Ackerboden mehr, sondern nur noch Farbspuren in sieben verschiedenen Farben: Vier unterschiedlich hellen Abstufungen von Grün, Hellbraun, Dunkelbraun und ein wenig Gelb. Nicht nur der plastische Effekt war verschwunden, auch die Konturen der einzelnen Pflanzen hatten sich aufgelöst.

Ein KI-basiertes Skalierungsverfahren könnte damit wenig anfangen; es würde allenfalls die Pinselspuren höher auflösen, aber keine Motivdetails dazu erfinden können. Allerdings wäre das auch nicht nötig, denn wir wissen ja, dass wir es nicht mit einer Fotografie, sondern einem Ölgemälde zu tun haben, dessen kleinste Bausteine Pinselstriche sind. Wenn aus der Nähe keine Pinselspuren sichtbar würden, dann könnte etwas damit nicht stimmen.

Tritt man nun aber wieder einen Schritt zurück, werden erneut einzelne Pflanzen sichtbar, und auch der plastische Eindruck stellt sich wieder ein. Wir sehen keine Farbkleckse, die wir als Pflanzen interpretieren, sondern wir meinen eben diese Pflanzen zu sehen.

Warum das so ist, verstehe ich besser, seit ich vor ein paar Monaten Andy Clarks The Experience Machine – How Our Minds Predict and Shape Reality gelesen habe. Andy Clark, Professor für kognitive Philosophie an der University of Sussex (sein Name war mir noch aus meiner Zeit als KI-Wissenschaftler vertraut), weist darauf hin, dass die neuronalen Netze unseres visuellen Kortex (und nicht nur diese) keine Einbahnstraße für die Impulse sind, die von Nervenzelle zu Nervenzelle wandern. So, also in einer Richtung, werden nämlich die meisten künstlichen neuronalen Netze durchlaufen, die aktuellen KI-Systemen zugrunde liegen. Vielmehr gibt es in unserem Gehirn mindestens ebenso viele Nervenbahnen, die in der Gegenrichtung verlaufen, also von den tieferen Schichten des Nervensystems zu den Sinneszellen.

Es ist nicht so, dass das Gehirn rohe Sinnesdaten immer weiter interpretiert, bis es schließlich herausgefunden hat, mit was wir es zu tun haben, also aus unterschiedlich grünen Flecken auf Blätter und daraus auf eine Pflanze schließt. Stattdessen geht es von einer Vorstellung aus, was wir vermutlich sehen werden, und beeinflusst die für einen früheren Verarbeitungszustand zuständigen Nervenzellen und sogar die Sinneszellen so, dass sie das Erwartete auch dann erkennen, wenn die Sinnesdaten alleine dazu gar nicht ausreichen.

Diese Art der Verarbeitung von Sinnesdaten hat sich im Laufe der Evolution bewährt, denn wer erst flieht, wenn es absolut zweifelsfrei klar ist, dass er einem Tiger gegenüber steht, wird vermutlich gefressen, bevor er sich fortpflanzen kann. Mit einem visuellen Kortex, der ein Zusammentreffen mit Fressfeinden voraussagt und die Nervenzellen dazu ermuntert, diese zu erkennen, steigt die Überlebenswahrscheinlichkeit. Und sei es auf Kosten gelegentlicher Irrtümer, weil da gar kein Tiger ist.

Wir kennen so etwas aus dem täglichen Leben, auch wenn wir heutzutage selten Tigern begegnen. Beispielsweise überlesen wir immer wieder einen Tippfehler, weil wir ja wissen, welches Wort dort stehen muss. Werfen wir dann am nächsten Tag noch einmal einen frischen Blick auf den Text, springt uns der Fehler ins Auge, und wir verstehen nicht mehr, wie er uns jemals entgehen konnte. Aber wir waren ja überzeugt, das richtig geschriebene Wort gesehen zu haben – die Voraussage wog schwerer als das Urteil der rohen Sinnesdaten. Ein anderes Beispiel, das Clark gleich im ersten Kapitel erwähnt, ist das trügerische Gefühl, das Handy hätte in der Tasche vibriert, wenn man mit einer Nachricht rechnet – selbst wenn das Handy gar nicht in der Tasche steckt. Das Phänomen ist als phantom vibration syndrome bekannt, und es zeigt sich um so häufiger, je höher der Stresslevel ist.

Die Maler des Impressionismus mussten sich gar nicht bemühen, feinste Details auf die Leinwand zu bringen, so lange wenige Pinselstriche ausreichten, uns sehen zu lassen, was wir zu sehen erwarten. Dass das Hochskalieren per KI heute so nützlich erscheint, liegt allein daran, dass wir zwar sichtbare Pinselspuren akzeptieren, grobe Pixelstrukturen oder auch JPEG-Artefakte jedoch nicht. Selbst deutliche Spuren, die der Pinsel hinterlassen hat und die ersichtlich nicht zum Motiv gehören, stören uns nicht – wie etwa in diesem Bild von Max Liebermann (Die Netzflickerinnen), das ebenfalls in der Kunsthalle zu sehen ist:

Aber wer weiß: Vielleicht ist das bloß ein acquired taste und wir werden uns irgendwann an sichtbare Pixel gewöhnen, so wie wir uns an Pinselstriche gewöhnt haben. Verlassen würde ich mich jedoch nicht darauf.

Übrigens: Wenn Sie sich jetzt selbst fragen, ob die Impressionismus-Ausstellung etwas taugt: Geht so. Sie ist eine halbe Stunde wert, falls Sie sowieso in der Kunsthalle sind, aber eine weite Anreise nach Hamburg lohnt sich dafür nicht.

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft:

Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Das DOCMA-Magazin können Sie als Print-Ausgabe und als E-Paper kaufen oder abonnieren. Alternativ bieten wir die Inhalte der jeweils aktuellsten DOCMA-Ausgabe auch im Abo in Form der DOCMA2go als wöchentliche E-Mails an (verteilt über 13 Wochen).

Zu den Print-Abos | Zu den Digital-Abos

Sehr schöner Artikel!!!

Es ist einfach so: Ich mag Pixelstrukturen nicht! Aber, ob das in Zukunft für mich weiter so gilt, ist die Frage und was für andere gilt ist eh offen.

Selbst alte schlechte Polaroids z.B. haben in gewissen Kreisen einen Kultstatus. Auch aktuelle Fotos werden manchmal in diese Richtung entwickelt und ….hoppla… da gefällt mir manches sogar!

Gruß Wieland