Sound and the City

Einer chinesisch-amerikanischen Forschergruppe ist die Entwicklung einer KI gelungen, die zu kurzen Geräuschschnipseln Bilder einer passenden Umgebung imaginiert. Mich erinnert das an eine Idee, die ich vor 30 Jahren hatte.

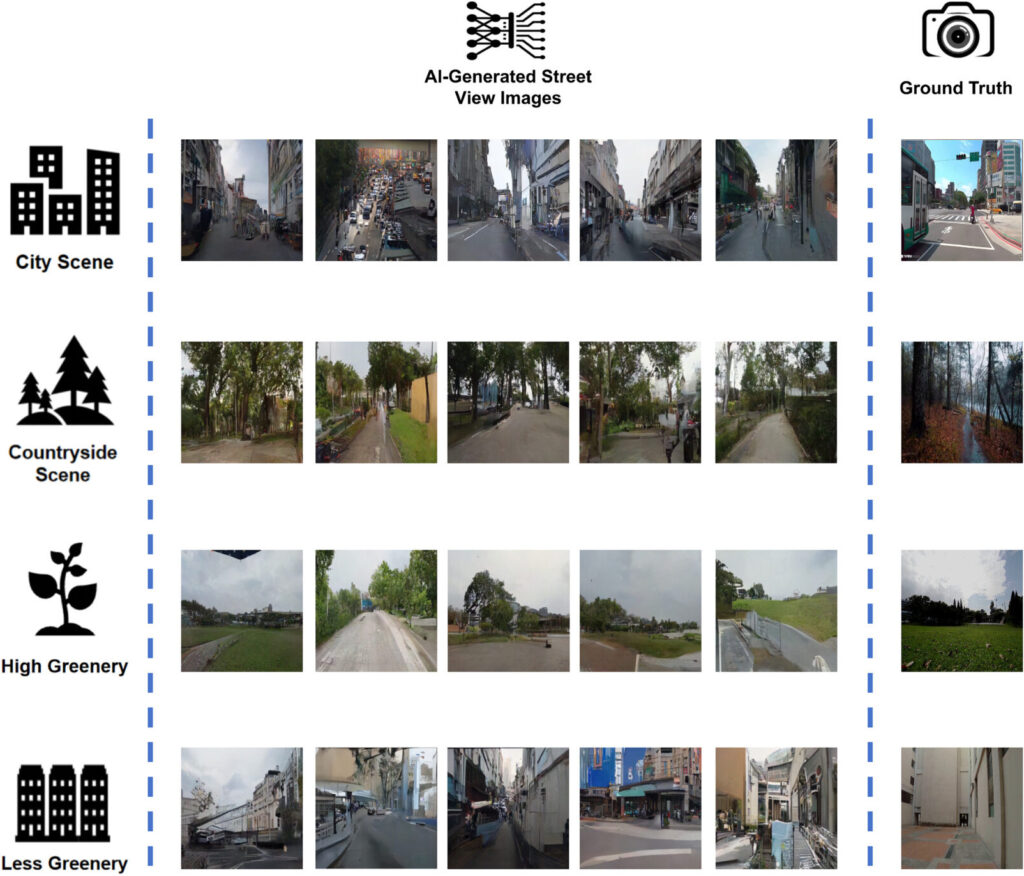

Generative KI-Systeme, die zu einem Prompt-Text mehr oder minder gut passende Bilder erfinden, sind ja mittlerweile ein alter Hut. Yonggai Zhuang, Yuhao Kang, Teng Fei, Meng Bian und Yunyan Du haben nun ein KI-Modell auf der Basis von Stable Diffusion mit jeweils 10-sekündigen Tonaufnahmen von Umgebungsgeräuschen und dazu gehörigen Bildern trainiert, das daraufhin die zu den verschiedensten Geräuschen passende Umgebung visualisiert. Zum Rascheln von Blättern im Wind und zirpenden Zikaden findet die KI ebenso überzeugende Bilder wie zum Lärm einer vielbefahrenen Straße.

Darüber, dass die typischen Geräusche an einem Ort bereits ein gutes Bild davon vermitteln könnten, wie es dort aussieht, hatte ich Anfang der 90er Jahre schon mal nachgedacht. Bevor ich in fremde Städte reiste, besorgte ich mir durchweg einen Stadtplan, um mich schon mal grob zu orientieren – Google Maps gab es damals noch nicht. Ich habe zwar einen guten Orientierungssinn, aber es schadet nicht, vorbereitet zu sein. Bis heute ist es so, dass ich, kurz nachdem ich im Hotel eingecheckt habe, erst einmal zu Fuß die nähere und weitere Umgebung erkunde. Verirrt habe ich mich selten, ob in New York, Tokyo, Hong Kong oder San Francisco – nur in Venedig, aber da ist das normal.

Beim Vergleich meiner Erinnerung an den Stadtplan mit den Erlebnissen vor Ort fiel mir auf, dass solche Pläne zwar zur Orientierung taugten, aber kaum einen Eindruck von der Umgebung vermittelten. Zwängten sich Autokolonnen durch eine Straße, oder war es eine verkehrsberuhigte Zone? War sie von Hochhäusern gesäumt, oder gab es nur eine niedrige Bebauung? Standen schattenspendende Bäume am Straßenrand, oder gab es überhaupt kein Straßenbegleitgrün? Wie viel Platz hatten Fußgänger und Radfahrer, und war die Fahrbahn asphaltiert oder mit Steinen gepflastert? War es eine Wohngegend, oder gab es Geschäfte, Bars und Restaurants?

Heutzutage würde man sich mit Google Street View oder dessen Apple-Pendant einen Eindruck verschaffen (übrigens ist Deutschland bei Apple längst nicht so flächendeckend verpixelt wie bei Google; als Apple seine Kamerawagen durch die Straßen schickte, hatte sich die durch Google ausgelöste Hysterie nämlich schon wieder gelegt), aber vor 30 Jahren war das noch nicht erfunden. Ich entwickelte damals eine andere Idee: Wie wäre es, wenn man in jeder Straße, oder sagen wir, alle 100 oder 200 Meter, kurze, repräsentative Aufnahmen der Umgebungsgeräusche aufnehmen würde? Vielleicht gleich mehrmals, morgens, mittags und abends, denn wo es mittags ruhig ist, kann es ein paar Stunden später ein lautes Nachtleben geben. Die digitalisierten Geräuschschnipsel könnte man mit einem ebenso digitalen Stadtplan verknüpfen, und man bräuchte dann nur irgendeinen Punkt auf dem Plan anzutippen, um die dortige Geräuschkulisse zu einer frei gewählten Tageszeit abzurufen. Idealerweise sollte es dafür ein portables Gerät geben, das man überall dabei haben könnte.

Just um diese Zeit, nämlich 1993, hatte Apple seinen ersten Personal Digital Assistant (PDA) eingeführt, das Newton MessagePad. Das schien mir gut zu meiner Idee zu passen, nur konnte ich mir damals keines leisten. Nachdem ich mir 1996 dann endlich das weiterentwickelte MP 120 und dazu Apples Entwicklungsumgebung gekauft und erste Anwendungen dafür programmiert hatte, wurde mir allerdings klar, dass es für meine Anforderungen entschieden untermotorisiert war. Erst das MP 2100 von 1997 wäre marginal geeignet gewesen, aber kurz nach dessen Markteinführung stellte der zu Apple zurückgekehrte Steve Jobs die ganze Produktlinie ein. (Ich hatte mir dann trotzdem noch ein MP 2100 und einen eMate 300 – einen Newton mit Tastatur, ein Frühwerk von Jonathan Ive – gekauft.) Davon abgesehen beschäftigte ich mich zu diesem Zeitpunkt ohnehin mit anderen Themen und hatte meine Idee, den Charakter eines Ortes durch seine typische Geräuschkulisse zu beschreiben, längst aus den Augen verloren. Oder Ohren, wie man in diesem Fall wohl sagen müsste.

Bis ich nun auf das oben erwähnte KI-Projekt stieß: Wenn man sogar einer KI beibringen kann, was bloße 10 Sekunden Geräusche über die Umgebung der Aufnahme aussagen, und diese daraufhin eine erstaunlich getreue Ansicht des Ortes generieren kann, dann war meine damalige Grundidee wohl gar nicht so falsch gewesen.

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft: Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.