Sind Digitalbilder wirklich digital?

Im ersten Jahrzehnt dieses Jahrhunderts, schneller als allgemein erwartet, wurde die analoge Silberhalogenidfotografie weitgehend durch die Digitalfotografie verdrängt. An dieser geschichtlichen Tatsache lässt sich nicht deuteln, aber verwenden wir dabei die richtigen Begriffe? Produziert die Silberhalogenidfotografie wirklich analoge Bilder und sind vermeintliche Digitalbilder wirklich digital? Es ist nicht so einfach, wie man denkt …

Wenn es darum geht, den Unterschied zwischen analog und digital zu erklären, wird oft angeführt, analoge Werte seien kontinuierlich – zwischen zwei nahe beieinander liegenden Werten gäbe es immer noch einen Wert, der zwischen beiden liegt. Digitale Werte seien dagegen diskret – „diskret“ nicht in dem Sinne, dass sie nichts ausplaudern, sondern in der Bedeutung, dass es nur eine begrenzte Zahl verschiedener Werte gibt. Auch die deutsche Wikipedia erklärt die Analogtechnik so: „Somit kann bei der Analogtechnik ein Signal in einem zeitlichen Verlauf unendlich viele Wertigkeiten besitzen.“ Doch das stimmt nicht so ganz.

Dank der Quantenphysik wissen wir seit über 100 Jahren, dass physikalische Größen keineswegs kontinuierlich sind, sondern gequantelt; sie können also ebenfalls nur diskrete Werte annehmen. Für die Belange der Fotografie bedeutet das konkret, dass Licht als Lichtquanten (Photonen) auf Silberhalogenidkristalle oder Sensorpixel trifft, und die Zahl der während einer Belichtung registrierten Photonen ist immer eine ganze Zahl – es gibt keine halben Photonen. Entsprechendes gilt für die Zahl der Elektronen, die in einem Sensorpixel gespeichert werden, und die der Zahl der absorbierten Photonen proportional ist – auch Elektronen gibt es nur am Stück und nicht in kleineren Teilen. Wenn wir also die Helligkeit an einer Stelle des Bildes beschreiben wollen, dann stehen uns dafür immer nur diskrete Werte zur Verfügung. Wenn man die gesammelten elektrischen Ladungen digitalisiert, bei einem aktuellen Analog/Digital-Wandler typischerweise mit 14 Bit, erhalten wir digitale Werte zwischen 0 und 16383. Bei aktuellen Sensoren liegt dieser ganzzahlige Wertebereich in derselben Größenordnung wie die Zahl gesammelter Photonen beziehungsweise Elektronen. Die analogen Werte sind also erstens nicht kontinuierlich, sondern diskret, und zweitens erlauben die entsprechenden digitalen Werte eine ebenso feine Differenzierung. In dieser Hinsicht gibt es also keinen Unterschied zwischen analog und digital.

Worin besteht dann aber dieser Unterschied, wenn er nichts mit der Unterscheidung zwischen kontinuierlich und diskret zu tun hat? Der Begriff „analog“ bezieht sich auf eine Analogie – oft eine Proportionalität – zwischen verschiedenen Größen. Beispielsweise gibt es im klassischen, analogen Fieberthermometer eine Quecksilbersäule, die ihre Länge analog zur Körpertemperatur ändert, und auf einer Skala kann man anhand der Länge der Quecksilbersäule die Temperatur ablesen. Ein modernes digitales Fieberthermometer zeigt die gemessene Körpertemperatur dagegen direkt als Zahl an. Eine analoge Sonnenuhr gibt den Sonnenstand und damit die Tageszeit über den Schatten eines Polstabs wieder, der sich analog zur Sonne bewegt; eine analoge mechanische Uhr verwendet wiederum einen Stundenzeiger, der sich seinerseits analog zum Schatten des Stabs einer Sonnenuhr dreht. Eine Digitaluhr aber zeigt die Zeit als Zahl der Stunden und Minuten nach Mitternacht an.

Digitale Werte können nicht nur Zahlen, sondern auch Buchstaben oder beliebige andere Symbole sein. Wie groß diese Symbole geschrieben werden, ist ohne Belang, und auch ihre Anzahl ist nicht entscheidend: 0,0001 ist eine kleinere Zahl als 1,0 und −1,0 ist noch kleiner. Ein Wal ist größer als eine Ameise, und auch als AMEISE wächst sie nicht. Was die Symbole bedeuten, wird durch das System bestimmt, dessen Teil sie sind, im Falle von Zahlen also die Arithmetik und bei Buchstaben die verwendete Sprache. Es gibt keinerlei Analogien zwischen den Symbolen und dem, was sie beschreiben.

Ist ein Silberhalogenidbild, also etwa ein Abzug auf lichtempfindlichem Fotopapier, in diesem Sinne ein analoges Bild? Da Rot im Bild für das Rot des Motivs steht, Grün für Grün, Weiß für Weiß und Schwarz für Schwarz, liegt hier der Trivialfall einer Analogie vor: Man repräsentiert alle Farbtöne und Tonwerte durch sich selbst. Der Unterschied zwischen Bild und abgebildeter Realität besteht lediglich darin, dass das Bild nur zwei statt drei Dimensionen hat, und dass die Abbildung kleiner oder größer als das Original sein kann. Im Grunde ist es eher eine Kopie als eine Analogie.

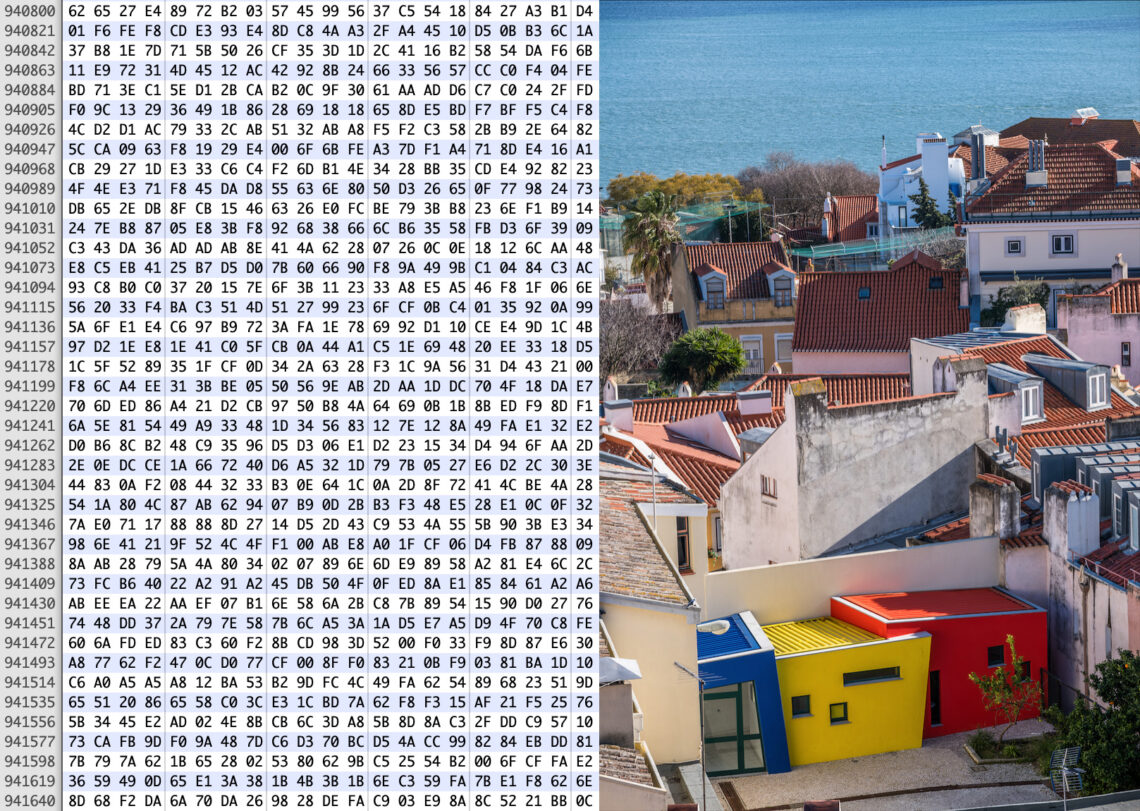

Und ist ein Digitalbild wirklich digital? Vergleichen wir es einmal mit den klassischen Beispielen für die Digitaltechnik. Beim digitalen Fieberthermometer sagt uns ein Blick auf die Zahl im Display, ob wir Fieber haben, und die Anzeige einer Digitaluhr verrät uns die Tageszeit. Ein Digitalbild wird als Datei gespeichert, die ebenfalls Zahlen enthält, aber wir öffnen eine solche Datei normalerweise nicht mit einem Hex-Editor, um uns diese Zahlen anzuschauen. Wenn wir es täten, könnten wir ihnen unmöglich ansehen, was im Bild zu sehen ist. Nicht einmal im vergleichsweise einfachen Fall einer unkomprimierten Datei, in der jedes ein Byte für die Helligkeit in der Rot-, Grün- oder Blaukomponente eines RGB-Pixels steht – die komplexeren JPEG-Dateien bergen noch einmal eine ganz andere Herausforderung.

Tatsächlich betrachten wir Digitalbilder natürlich auf dem Bildschirm angezeigt oder auf Papier ausgedruckt, und diese Bilder sind dann wieder im oben beschriebenen Sinne analog: Rot steht für Rot, Grün für Grün, Weiß für Weiß und Schwarz für Schwarz.

Die Dateien, die Digitalkameras speichern, sind nicht so sehr Digitalbilder; vielmehr enthalten sie digitale Daten, aus denen ein Computer mit einem Bildschirm oder einem Drucker analoge Bilder erzeugen kann. Insoweit sie digital sind, sind sie keine Bilder, und sobald sie als Bilder sichtbar werden, sind sie nicht mehr digital. Strenggenommen gibt es also gar keine Digitalbilder.

Dagegen sind echte digitale Medien, die man unmittelbar interpretieren kann, ohne dass sie erst in eine analoge Repräsentation umgewandelt werden müssten, ein alter Hut. Schon vor mehr als 5000 Jahren gab es Keilschrifttafeln mit Texten, die jeder, der die Zeichen und die verwendete Sprache kannte, ohne weitere Hilfsmittel lesen konnte. Während also digitale Bilddaten eine Maschine benötigen, die daraus Bilder erzeugt, erfordert ein digitaler Text kein Vorlesegerät. Und das funktioniert auch umgekehrt: Wer die Schrift beherrscht, kann Texte unmittelbar niederschreiben (beziehungsweise die Buchstaben in den weichen Ton einer Keilschrifttafel drücken). Dagegen können wir kein Bild „malen“, indem wir die Bytes einer digitalen Bilddatei eintippen – selbst wenn wir die für Millionen von Zahlen (eine unkomprimierte Bilddatei mit 24 Megapixeln enthält 72 Millionen Bytes) nötige Zeit hätten. Dazu brauchen wir eine Malsoftware oder, wenn uns das Talent zur bildenden Kunst fehlt, eine Digitalkamera.

Aber stimmt dann wenigstens die Bezeichnung „Digitalkamera“? Teilweise schon. Der Sensor ist noch ein analoges Bauelement, denn er setzt die Energie der während der Belichtung einfallenden Photonen in analoge elektrische Ladungen um. Der A/D-Wandler ist nur noch zur Hälfte analog und arbeitet in der anderen Hälfte digital. Die anschließende interne Bildbearbeitung bis zur fertigen JPEG-Datei erfolgt rein digital, aber wenn die Aufnahme zur Kontrolle auf dem Display erscheint, betrachten wir schon wieder ein analoges Bild. So ist eine Digitalkamera eigentlich eine hybride Kamera aus analogen und digitalen Bestandteilen.

Hallo der Artikel ist ziemlich haarspaltend, aber mehr als interessant. Besonders die Unterscheidung zwischen Speicherung (als digitale Werte ) und Darstellung auf Papier oder Bildschirm (analog) finde ich spannend.

Sind denn die analogen Bilder wirklich analog. Die Farbstoffe sind ja in chemischen diskreten Partikeln auf dem Film gespeichert und somit diskretisiert – was ja einer digitalisierung grob entspricht. So analog / kontinuierlich sind sie nicht

„So analog / kontinuierlich sind sie nicht“ Ja, aber wie ich schon schrieb, bedeutet „analog“ eben nicht „kontinuierlich“, auch wenn das leider oft so erklärt wird. Kontinuierliche, also immer weiter teilbare physikalische Größen gibt es eigentlich gar nicht. Und es ist in der fotografischen Praxis nicht einmal so, dass die analogen Größen, wenn sie schon nicht kontinuierlich sind, doch wenigstens viel feiner differenzieren würden als eine grobschlächtige Digitalisierung. Tatsächlich lösen die A/D-Wandler unserer Kameras schon mit 14 Bit so fein auf, dass man mit 16 Bit oder mehr schon Photonen beziehungsweise Elektronen spalten müsste. Und während Haare zu spalten nur sehr schwierig ist, ist das Spalten von Photonen oder Elektronen schlichtweg unmöglich. Auf dem Bildschirm sieht es zwar noch etwas anders aus, weil wir mit 8 Bit pro Kanal nur 256 und mit 10 Bit nur 1024 Tonwerte differenzieren können, aber da der Computer an dieser Stelle bereits von linearen in logarithmische Werte umgerechnet hat, kommen wir auch damit gut zurecht.

Wenn wir nun die quantenphysikalischen Gedanken haar- und kernspaltend weiter spinnen, gelangen wir in eine Situation, in der das, was wir gemeinhin physikalisch als materiell wahrnehmen und fotografisch ablichten können, letzlich nur noch imaterielle Felder sind. Wir finden uns in einer Welt wieder, in der auch die Zeit nicht mehr kontinuierlich, sondern nur quantisiert als Planck-Zeit existiert. Zumindest gedanklich können wir in dieser Realität der Frage nachgehen, was den auf dem Bild erscheint, wenn wir den Auslöser wenige 10 hoch -45 Sekunden zwischen der quantenphysikalisch existierenden Zeit drücken.

Richtig! Nichts. Weil auch wir und unsere Digitalkamera zu diesem Zeitpunkt nicht existierten.

Guten Morgen!

Die Haarspaltereien sind zwar, wenn man so sagen will, charmant aber nicht zielführend.

Was wirklich zählt zur Unterscheidung ist: kann ich das Bild angreifen oder nicht?

Das sogenannte „analoge“ Foto muss(te) immer auf Papier belichtet oder gedruckt sein, um es zu sehen. Es ist real, greifbar, also vorhanden.

Das digitale Bild ist das was uns ein Monitor zeigt, sofern er entsprechend programmiert ist (man denke allein an die unendlichen Diskussionen und Probleme mit Farbräumen an unterschiedlichen Monitoren …). Das kann ich nicht angreifen, das ist praktisch nur heisse Luft, eine theoretische Anmutung.

Lassen wir uns nicht – auch nicht wie hier durch die Hintertür – dazu bringen, die digitale Welt als real anzusehen!

nicht genügend, setzen ! du hast scheinbar nicht verstanden, was hußmann gschrieben hat.

und das war alles andere als haarspaltereien, sondern fakten !!!

Anregung an die Nerds:

Wer schreibt einen Algorithmus, der digital abgespeicherte Bilddaten statt in Farb- und Sättigungswerte in Töne umrechnet?

100 % Sättigung entspricht einem Heidenlärm von 120 dB, die Farben werden vom tiefsten fast-Infrarot bis zum fast-Ultraviolett auf einen Bereich von 16 Hz bis 20 kHz abgebildet.

Allerdings fürchte ich, dass schauerliche Furztöne dabei herauskommen werden 😉

Man bräuchte nur mal einem Faxsignal zu lauschen.

Oje.

Dazu müsste ich mich ja eigens in eine deutsche Behörde oder eine Arztpraxis begeben…

😉

danke für den aufschlußreichen artikel!

nicht überall wo „KI“ steht iss die auch drinnen 😉