Wir haben in DOCMA ja schon oft über Neuronale Netze berichtet, die allein aufgrund einer kurzen Textvorgabe eindrucksvolle und detailreiche Bilder generieren. Und natürlich können dabei, beabsichtigt oder zufällig, auch Szenen entstehen, in denen Wörter – etwa als Neon-Reklame oder Inschriften – auftauchen. Doch bei dieser Aufgabenstellung kam bei Doc Baumanns Versuchen meist wenig wirklich Brauchbares heraus.

Stable Diffusion; Prompt: the name „DOCMA BAR“ in neon letters at the front of a bar in new york, soho

KI-generierte Bilder führen sehr oft zu unerwarteten Ergebnissen. Das macht sie nicht schlechter (oder besser) als vertraute Bilder, aber es zeigt das – zumindest derzeit noch – bestehende Problem, dass die Resultate weit von dem entfernt sein können, was man eigentlich wiedergeben wollte. Es gibt aber noch eine weitere Schwierigkeit: Während einerseits zahllose Details in diesen Bildern auftauchen, die man nie vorgegeben und schon gar nicht erwartet hat, kommen die Systeme manchmal mit den allereinfachsten Selbstverständlichkeiten nicht zurecht. So mag man es noch für Spezialwissen halten, dass ein Schachbrett nicht nur aus weißen und schwarzen Feldern besteht, sondern dass es 8 × 8 sind und die sich regelmäßig abwechseln. Doch selbst in Kinderzeichnungen ist höchst selten zu sehen, dass eine menschliche Figur drei oder vier Arme oder Beine hat oder die Anzahl und Position von Händen und Fingern Variationen zeigt, die in der Realität so nicht vorkommen.

Überhaupt sind solche KIs nicht gerade Weltmeister im Zählen. Vor die Aufgabe gestellt, eine bestimmte überschaubare Anzahl von Objekten darzustellen, geben sie sich zwar rührende Mühe in der Ausgestaltung dieser Gegenstände und der Integration in ihre Umgebung – aber dass es etwa genau sechs sind und nicht viel mehr oder weniger, ist reiner Zufall.

Buchstaben und Wörter dagegen sollten eigentlich zu den Objektklassen gehören, die sie mühelos beherrschen. Schließlich agieren sie ja auf der Grundlage von Texteingaben und schaffen es, mehr oder weniger genau, das darzustellen, was in Form von Wörtern vorgegeben wurde.

Wombo; Prompt: times square new york, neon signs, night, rain

Ist die Aufforderung, Text darzustellen, Bestandteil der Vorgabe, so ist es die Regel, dass die Resultate kaum etwas mit der Eingabe zu tun haben; Texte als Bedeutungsträger sind offenbar etwas ganz anderes als Buchstaben, die visuelle Muster darstellen. So hatte ich beim folgenden Bild als „Prompt“ (Textvorgabe) geschrieben: Foto eines Außerirdischen vom Mars in Form einer Gießkanne“. Davon ist wenig zu erkennen; immerhin dürfte der Berg im Hintergrund der riesige Vulkan Olympus Mons auf dem Mars sein. Von einem einzufügenden Text hatte ich nichts gesagt, und dieser hat zudem mit dem Prompt nichts zu tun. Noch interessanter jedoch ist in diesem Zusammenhang, dass die Buchstaben zwar auf den ersten Blick recht vertraut erscheinen, zwei davon sich aber bei näherer Betrachtung als Phantasiegebilde entpuppen – wenn auch typographisch überzeugend angepasste. Überhaupt sind die Textdarstellungen der KIs nicht willkürlich, also etwa keine Mischung unterschiedlicher Schriftstile oder -familien, sondern auch dann formal einheitlich, wenn Phantasiezeichen generiert werden.

Stable Diffusion; Prompft: detaiiled photography of an alien from mars looking like a watering can

Betrachten wir ein paar weitere Beispiele. Den Prompt „Times Square in New York mit Neonreklame, bei Nacht, Regen“ (oben) hatte ich gewählt, weil an den Fassaden viele Buchstaben vorkommen. Auch hier wirkt auf den ersten Blick alles vertraut – auf den zweiten jedoch erkennt man nur Typo-Durcheinander. In einem schon früher erzeugten „Kupferstich“ stehen zwei beschreibende Unterzeilen, doch auch sie sind bedeutungsloses Gekritzel.

Stable Diffusion; Prompt: piranesis carceri, in the style of a

fine and detailled etching by duerer like duerers melencholia

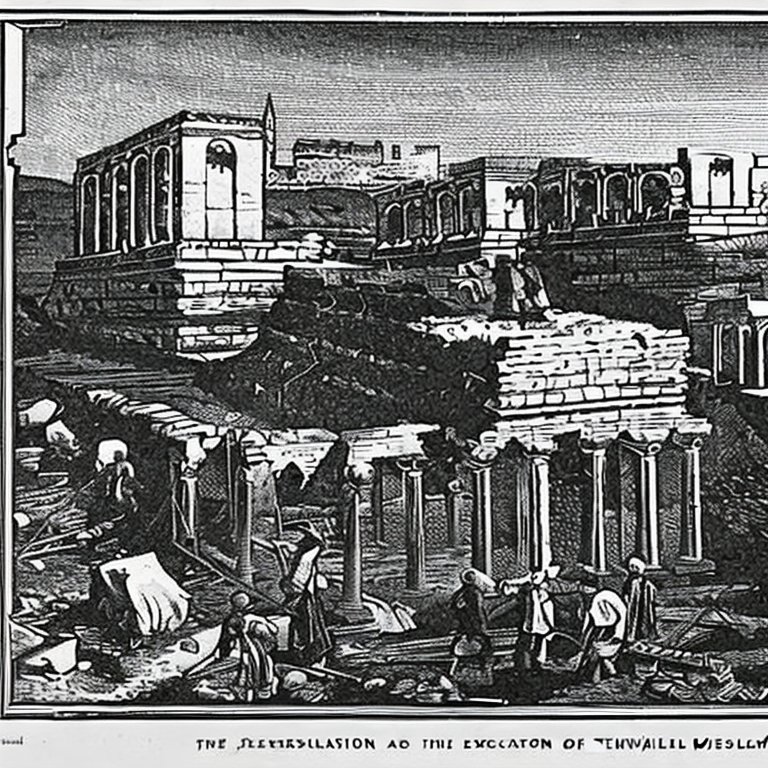

Stable Diffusion; Prompt: the excavation of the temple of Jerusalem, in the style of the black and white woodcuts of the illustrated london news

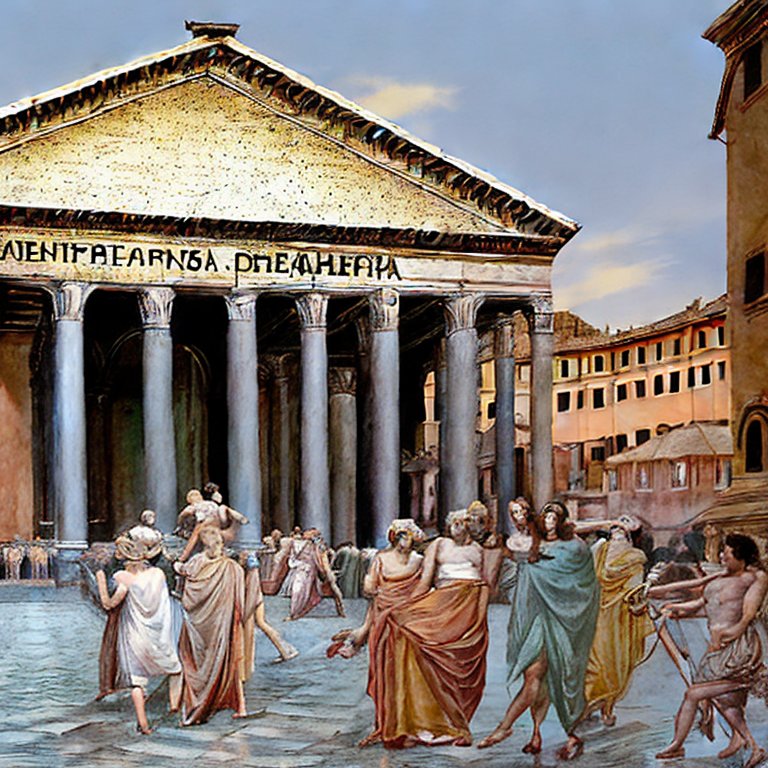

Ist das immer so? Seltsamerweise nicht. Beim folgenden „Stich“ hatte ich vorgegeben: „the excavation of the temple of Jerusalem, in the style of the black and white woodcuts of the illustrated london news“. Und erstaunlicherweise ist dort als Unterschrift näherungsweise zu lesen: „The Illustration of the Excavation of the wall …“, danach wird’s wieder unleserlich. Eine Serie von Bildern, die aus dem Prompt „Pantheon des Marcus Vipsanius Agrippa in Rom“ entwickelt wurden, zeigte bei allen Generatoren die Inschrift am Giebel, meist jedoch wie hier mit Phantasiezeichen, während in manchen Fällen zumindest Bruchstücke wie „MARC…“, „…IPPA“ oder „PAN…“ zu erkennen waren.

Stable Diffusion; Prompt: the pantheon in rome of marcus vipsanius agrippa, in the style of alma taddema

Später ließ ich eine Inschrift auf einer Marmortafel mit Agrippas Namen erzeugen. Ergebnis: Auch hier stets höchstens einzelne wiedererkennbare Buchstabenkombinationen – aber bemerkenswerterweise nahezu jedes Mal in den passenden historischen römischen Schriftformen Quadrata oder Rustica.

Stable Diffusion:; Prompt: the inscription „marcus vipsanius agrippa“ on a marble tablett in the wall of an old roman building

Weitere Versuche mit Tätowierungen funktionierten mit Bildvorgaben wie Porträts hervorragend; der Wunsch jedoch, dass jemand das Wort „DOCMA“ auf der Schulter trägt, wurde nur in ganz wenigen Fällen näherungsweise umgesetzt. Meist entstanden ästhetisch ansprechende Zeichen ohne Bedeutung, einmal immerhin „DOCMOM“ und einmal „DOC“.

Wombo; Prompt: a portrait of Johnny Depp as a tattoo one the shoulder of a woman

Wombo, Prompt: the word DOCMA as a tattoo on the shoulder of a woman

Stable Diffusion; Prompt wie zuvor

Stable Diffusion; Prompt wie zuvor

Ähnlich bei der Aufgabe, die Titelseite für eine Biographie von Sir Charles Warren zu gestalten (ohne explizite Vorgabe, dass der Name dort auftauchen soll): Das richtige Gesicht von Warren kam nie vor, aber gelegentlich Wortfragmente, die an seinen Namen erinnern.

Stable Diffusion; Prompt: a cover illustration with the portrait of sir charles warren, in the style of the black and white woodcuts of the illustrated london news

Ebenso waren sehr viele Versuche nötig, um den Prompt lesbar umzusetzen: „the name „DOCMA BAR“ in neon letters at the front of a bar in new york, soho“. In einigen Fällen ließ sich das Gemeinte immerhin erahnen.

Auch wenn die Vorgehensweise von KI einer black Box gleicht, bei der man in der Regel nur sieht, was hineingeht und was herauskommt, ohne Kenntnis der Prozesse, die sich im Inneren abspielen, fragt man sich hier als Informatik-Laie, was da vorgeht. Klar, diese Neuronalen Netze sind mit zahllosen Bildern trainiert worden, wobei ihnen natürlich jemand mitteilen musste, was darauf zu sehen ist. Nur Bilder ins Gedächtnis zu schaufeln bringt ja nichts, wenn hinterher der getippten Eingabe „Times Square“ eine Bild-Ausgabe entsprechen soll, die ebendiesen Platz zeigt. Und auf visuelle Texterkennung beziehungsweise -darstellung sind diese Systeme offenbar nicht ausgerichtet.

Wäre das nun in jedem Fall so, könnte ich das ja noch nachvollziehen. Aber warum erscheinen dann mitunter doch mal die „richtigen“ Wörter oder zumindest Bruchstücke davon als Zeichen im Bild? Vielleicht ergeht es unserer armen KI ja so wie uns, die wir vielleicht gerade noch chinesische Schriftzeichen als solche erkennen, aber keine Ahnung haben, was sie bedeuten und ob sie genau so oder ganz anders aussehen sollten. Die Zeichnung unten hat ein des Chinesischen kundiger Freund generieren lassen. Nicht nur der graphische Stil überzeugt, auch die Zeichen sehen „echt“ aus – sie sind aber ebenso phantasievoll erfunden wie die oben gezeigten in lateinischer Schrift, nur fällt das den meisten von uns hier gar nicht auf.

Mit einem ähnlichen Problem habe ich letztens einige Stunden verbracht und dachte schon es liege an meiner Unfähigkeit den Beschreibungstext zu formulieren.

Ich wollte Dall-E dazu bringen, das Wort „Frieda“ auf ein rotes Wohnmobil zu schreiben. Die Ergebnisse waren wie von Ihnen beschrieben: Einige Male erschien zwar ein Wort mit teilweise übereinstimmenden Buchstaben, aber nie genau das Wort „Frieda“. Auch mit der Farbe des Wohmobils klappte es nicht: Von ca. 30 bis 40 Versuchen war nur bei wenigen das WoMo rot, in allen anderen Fällen stets rot mit einem weißen Dach.