Eine der besten Neuerungen der letzten Jahre in Photoshop sind »Generatives Füllen«, das »Entfernen-Werkzeug« und »Bild generieren«. In Version 2024 hatte all das noch deutlich besser als in Photoshop 2025 funktioniert. Was ist da los?

Übersicht

Das an sich geniale Entfernen-Werkzeug

Das »Entfernen-Werkzeug« ermöglicht durch simples Übermalen störender Bildstellen Retuschen, für die früher noch Expertenwissen mit Stempel- und Reparatur-Werkzeug notwendig war.

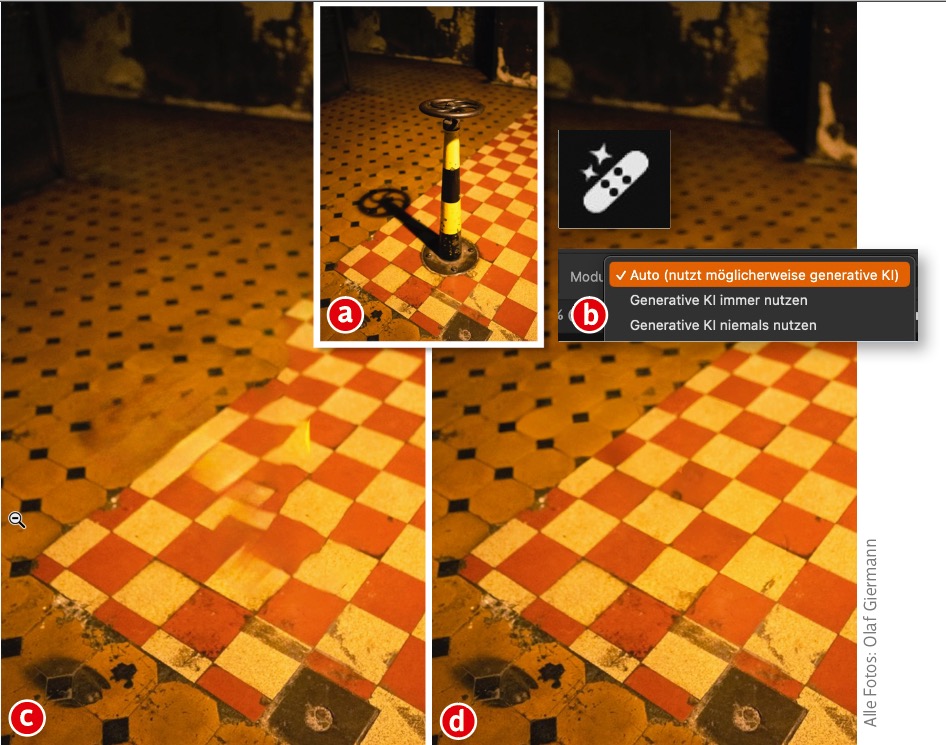

Wie gut das funktioniert(e), hatte ich begeistert in diesem Blog-Beitrag anhand dieses Beispiels zeigen können:

Auch im letzten Heft und in DOCMA2Go konnte ich nur Gutes berichten:

KI-Probleme in Photoshop

Hinweis: Bei all den hier beschriebenen Problemen geht es nicht um die KI-basierten Auswahl-Funktionen. Die könnten zwar besser sein, haben sich aber im Vergleich zu früheren Photoshop-Versionen nicht verschlechtert.

Mit der Umstellung auf Firefly Version 3 in Photoshop 2025 stolpere ich leider zunehmend über Probleme – sowohl bei »Bild generieren« als auch beim »Generatives Füllen«, die beide übrigens leicht unterschiedliche KI-Modelle nutzen und deshalb nicht dieselben Ergebnisse liefern (können).

Klar ist: KI-Modelle und deren Abstimmung sind immer ein Balance-Akt. Es gibt dabei kein Richtig oder Falsch, sondern nur eine Entscheidung zwischen Gut-genug und Lieber-nicht.

Mir ist aktuell nicht klar, ob Adobe angesichts der im Folgenden beschriebenen, offensichtlichen Probleme einfach die neuesten KI-Trainingsresultate ohne Rücksicht auf Verluste veröffentlicht, oder ob Adobes Testkriterien schlicht ungeeignet sind, diese Probleme in der tatsächlichen Praxis zu erkennen und korrekt einzuordnen. Ein Mysterium!

KI-Probleme bei „Bild generieren“

So liefert »Bild generieren« gern einmal bei Foto-Prompts so etwas – auch ohne verkorkste Finger völlig Unbrauchbares – ab, das es bei Firefly 2 nicht gab:

Wie ich in DOCMA 111 schrieb: „Oft wirken die Bilder sehr künstlich, Details sind überschärft, Gesichter zeigen übertriebene Hautstrukturen und fehlerhafte Augen. Hier besteht dringender Nachbesserungsbedarf.“ Weit über drei Monate später ist das KI-Modell jedoch offenbar kein Stück besser geworden.

KI-Probleme bei „Generatives Füllen“

»Generatives Füllen« (und »Generatives Erweitern«) erzeugt in der aktuellen Version für Retusche-Zwecke deutlich schlechtere Ergebnisse als das »Entfernen-Werkzeug«:

Das ist auch im Adobe-Community-Forum gemeldet und von vielen diskutiert worden (Link).

Ein ähnliches Beispiel wie meins zeigt User „Christian1979“, bei dem das Problem im Hinblick auf Struktur und Glaubhaftigkeit noch deutlicher wird:

Immerhin liefert in solchen Fällen das »Entfernen-Werkzeug« sichtbar bessere Ergebnisse – vielleicht, weil es auf einem älteren oder einem neueren KI-Modell basiert.

Im Forum hat der Adobe Senior Product Manager Stephen Nielson geantwortet (übersetzt mit DeepL), die ich hier kurz kommentiere:

Stephen Nielson: Beim Entfernen eines Bereichs sehen wir, dass GenFill in der Regel bessere Ergebnisse mit einer leeren Eingabeaufforderung (anstelle von „Haar“ oder „Nein“) erzielt. Generative Modelle können unberechenbar sein, aber das könnte in diesem Fall helfen.

Nein, das hilft nicht bei den gezeigten Problemen. Tatsächlich sind im aktuellen »Generatives Füllen«-Modell Beschreibungen wie »Entfernen« oder »Remove« hilfreich, um das Generieren von alternativen Objekten anstelle eines passenden Hintergrunds zu vermeiden.

Stephen Nielson: Wir sind uns des Problems bewusst, bei dem die Texturqualität geringer ist als erwartet, und wir untersuchen sowohl kurz- als auch langfristige Lösungen.

Da dürfen wir gespannt sein. Die Bewusstwerdung eines Problems ist der erste Schritt. Aber es ist wahrscheinlich nicht so, dass Adobe erst nach der Veröffentlichung plötzlich und ohne jedes Feedback von Prerelease-Testern über dieses Problem stolpert.

Stephen Nielson: Bei unseren internen Tests haben wir festgestellt, dass Image 3 Model im Durchschnitt qualitativ bessere Ergebnisse liefert als die Vorgängerversion. Wie ich bereits erwähnt habe, können generative Modelle unberechenbar sein. Es gibt viele Fälle, in denen das neue Modell besser ist, aber es gibt auch einige, in denen die Ergebnisse schlechter sind. Unsere Prioritäten für die nächste Version des Firefly-Modells sind eine gleichmäßigere Qualität und eine höhere Auflösung der Ergebnisse.

Hier verstehe ich den Testprozess von Adobe nicht. Ausnahmslos ALLE Nutzer, die KI-Funktionen von Photoshop einsetzen und mit denen ich mich seit Veröffentlichung von Version 2025 auf allen möglichen Plattformen und Wegen ausgetauscht habe, hatten eine Verschlechterung der Ergebnisse festgestellt. Say no more!

Stephen Nielson: Wie bereits erwähnt, können Sie immer noch auf das alte Modell zugreifen, indem Sie Photoshop 2024 (v25.x) verwenden. Sie können sowohl Photoshop 2024 als auch 2025 zur gleichen Zeit installiert haben.

Ja, ganz toll!

Ernsthaft: Eine alte Version zu empfehlen, weil die neue in einer Hinsicht schlechter ist, kann doch nicht ernst gemeint sein. So etwas sollte deutlich benutzerfreundlicher gelöst werden. Und dafür gibt es einfache Lösungen. Aber mich fragt natürlich keiner. ?♂️

KI-Probleme des „Entfernen-Werkzeugs“

Obwohl das »Entfernen-Werkzeug« beim Retuschieren, wie oben gezeigt, bessere Ergebnisse als »Generatives Füllen« produziert, liefert es in der aktuellen Version häufiger als zuvor schlechte Ergebnisse. Es fügt jetzt oft einfach neue Ersatz-Objekte ein, statt einen glaubhaften Hintergrund zu produzieren.

KI-Probleme: Aktueller Retusche-Vergleich durch Petapixel

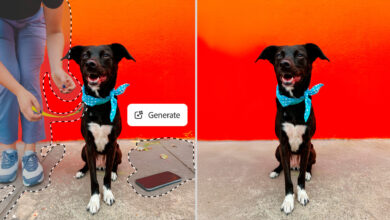

Beschämend für Adobe ist der aktuelle Vergleich der KI-Retusche-Ergebnisse von Photoshop und dem neuen AI Photo Clean Up von Apple (Petapixel-Blog).

Da kann ich die gezeigten Probleme fast durchweg bestätigen. Nur das erste Beispiel deutet auf einen Hardware-Fehler oder Bug hin:

Vor allem beim japanischen Bahnhof ist es mit Photoshops »Entfernen-Werkzeug« oder mit »Generatives Füllen« in Photoshop 2025 ohne etwas Glück fast unmöglich, störende Elemente zu entfernen, weil man ständig nur neue Gegenstände oder in verkorkster Weise Personen generiert:

Weitere Bild-Beispiele finden Sie in diesem Petapixel-Blogbeitrag, in dem Apples brandneue Clean-up-Funktion mit Adobes Ergebnissen verglichen wird: Apple vs. Adobe: One is Clearly Better at AI Photo Clean Up

Nach meinen ersten eher enttäuschenden Experimenten mit Apples Clean-Up und meinen früheren, sehr positiven Erfahrungen mit Photoshops »Entfernen-Werkzeug« begann ich diesen Blog-Beitrag mit der Intention, den reißerischen Petapixel-Artikel zu widerlegen. Aber leider muss ich nach vielen Tests in Photoshop 2025 dem dort Gesagten recht geben.

Was ist da los, Adobe? Ich verstehe zwar, dass KI-Modelle eine kniffelige Angelegenheit sind, aber vielleicht sollte man den Test- und Umfrageprozess angesichts des aktuell wieder sehr negativen Feedbacks einmal überdenken. Ich sag’s ja nur. 😉

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft: Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Die Empfehlung von Adobe, bei Problemen die alte Version zu nutzen, scheint die generelle Strategie zu sein. Ich hatte beim letzten Update von Lightroom eine ähnliche Erfahrung machen müssen. Nach stundenlangem Chat, an der angeblich dann auch noch die Fachabteilung mit einbezogen war, konnte man mein Problem mit der Synchronisation in der Cloud nicht helfen. Mein Angebot, den Analysebericht (den in solchen Fällen das Programm empfiehlt für den Fachbereich zu erstellen) hat man immer wieder dankend abgelehnt. Statt dessen war die „Lösung“ zu deinstallieren und wieder neu zu installieren, was ich abgelehnt habe, weil meine Voreintellungen dann auch futsch wären. Nach insgesamt 3 fast zweistündigen Sitzungen war die „Lösung“ von Adobe, die Vorgängerversion zu nutzen, weil in der die Probleme mit der Synchronisation nicht auftauchen. Ich habe mir dann die Mühe gemacht, den recht kryptischen 53 seitigen Diagnosebricht zu lesen (den die Fachabteilung ja angeblich nicht brauchte) und bin darin darauf gestoßen, dass es insgesamt 9 Fotos betraf, die das Problem mit der Synchronisation betraf. Nachdem ich diese aus der Synchronisatin genommen habe, war das Problem beseitigt. Fazit: die Qualität nimmt gefühlt ab und wird anscheinend auch von Adobe so hingenommen.

Als jemand, der in der IT-Branche und mit vielen Herstellen zusammen-arbeitet, kann ich bestätigen, dass das Ausbalancieren zwischen Qualität liefern und gleichzeitig Profit maximieren (ehrlicherweise aber nur Shareholder Value, denn das ist etwas gänzlich Anderes) seit langem in die falsche Richtung läuft. Wenn (zu hohe) Qualität dazu führt, dass die Aufwände steigen, wird korrigiert, also Aufwände für Qualitätskontrolle, Support etc. reduziert. Das so lange, bis negative Kundenstimmen (letztlich: sinkende Verkaufszahlen und damit wieder Shareholder Value) zu hoch werden. Dieser Zyklus ist jedoch kein kurzfristiger, sondern er läuft über Jahre. Dein Beispiel ist nur eines von vielen, leider.

Ich hoffe bald gibt es ein Midjourney Plugin, weil die jetzt auch ein Editor haben. Ist wohl euch entgangen. Wieder nur für Nutzer mit 10K Generierung offen. Aber der Editor hat es in sich. Da kann Photoishop einpacken.

Nö, ist uns nicht entgangen. Ich hab kurz vor Redaktionsschluss für das nächste Heft direkt nach Veröffentlichung des Editors noch eine Seite dazu ergänzt. Muss halt noch gedruckt werden. Ist eben ein Dinosaurier-Medium, bei dem der Asteroideneinschlag immer näher rückt in diesen schnelllebigen Zeiten.

Eine native Möglichkeit der Integration anderer KI-Modelle als Firefly wäre toll. Da gibt es zwar schon Panels wie Flying Dog und Co, die ich auch schon im Heft vorgestellt hatte, ganz problemlos und einfach ist das aber alles nicht. Wäre auch toll, um diese olle Zensur selbst harmlosester Prompts und Bildelemente endlich loszuwerden. Eine Midjourney-Integration wäre in Workflow und Qualität natürlich ein großer Wurf.

Oh ja definitiv, danke für den Hinweis. Bin auf die nächste Ausgabe gespannt, wenn sie eintrudelt 🙂

Mit diesem Hype um KI, insbesondere das generative Füllen, kann ich als klassischer Fotograf (noch) wenig anfangen. Am meisten ärgert mich, dass Adobe ständig unausgegorene Häppchen an neuen KI-Funktionalitäten einbaut und diese dann eine gefühlte Unendlichkeit lang nicht mehr anzurühren scheint, so zum Beispiel den neuralen Filter «Bildwiederherstellung».

Jammerschade, dass hier keine Bilder gepostet werden können. Wie gerne würde ich meine Entfernen-Werkzeug-Erfahrung teilen. Angeregt durch den Docma-Artikel und diesen Blogpost sowie meine bisherigen Erfahrungen (wieso funktioniert das plötzlich nicht mehr, obwohl das schon mal ging?) habe ich mich an einem Bild versucht.

Eine simple Aufnahme eines Artikels, den ich auf einer Verkaufsplattform anbieten wollte: Fernauslöser-Set auf einer neutralgrauen Filzmatte, also leicht strukturierter aber insgesamt homogener Hintergrund. Einen Teil des Sets habe ich übermalt und wollte ihn (nach mehreren erfolglosen Versuchen) letztlich mit dem Hinweis „mit Hintergrund füllen“ ersetzen lassen. Das Ergebnis kann sich sehen lassen! Der übermalte Teil wurde perfekt mit einer gelben Margerite (sofern ich das als nicht-Biologe identifizieren konnte) ersetzt. Gratulation, Adobe! Kein anderes Tool hätte das so gut hinbekommen. Seufz …

Hier können zwar keine Bilder hochgeladen werden, aber eingefügt werden können sie schon. Vorausgesetzt, dass Sie ein Bild, das Sie hier zeigen wollen, irgendwo bereits hochgeladen haben, können Sie es per HTML mit dem img-Tag hier einbinden.