KI kann nicht nur Bilder erzeugen, die wie Fotos, Gemälde oder Grafiken aussehen. Einige Systeme erlauben es auch, eigene Bilder hochzuladen, an deren Stil sich neu generierte orientieren. Noch spannender ist die Funktion etwa von Deep Dream Generator, solche Referenzbilder auch als Motivvorlagen für Bildvariationen per KI zu verwenden. Damit lassen sich nicht nur Details hinzufügen, sondern auch mangelhafte Bilder in brauchbare verwandeln. Doc Baumann hat ausprobiert, wo (derzeit) die Grenzen dieses Verfahrens liegen.

Es begann damit, dass mich Kaloyan von Deep Dream Generator in einer Mail darauf hinwies, dass diese KI nicht nur Bilder erzeugen, sondern auch über die Funktion „evolve“ modifizieren kann. Die Ergebnisse waren so beeindruckend, dass ich seitdem auch mit anderen Systemen generierte Bilder probeweise oft durch diesen Prozess laufen lasse. Deep Dream Generator lässt das für fast alle seiner Modelle – mit Ausnahme von AIVision – zu; ergänzend kann man in 10%-Sprüngen die Ähnlichkeit mit dem Ausgangsbild definieren – 10% „Effect strength“ ist sehr ähnlich, 90% eine recht freie Interpretation. Ergänzend wird immer ein Prompt benötigt, der in solchen Fällen natürlich am besten aus dem Ausgangsprompt des KI-generierten Bildes besteht, bei Fotos aus deren möglichst exakter Beschreibung (in Englisch).

Wie Sie im Folgenden sehen werden, habe ich für die Bildvariationen mit KI verschiedene Ausgangsbilder verwendet:

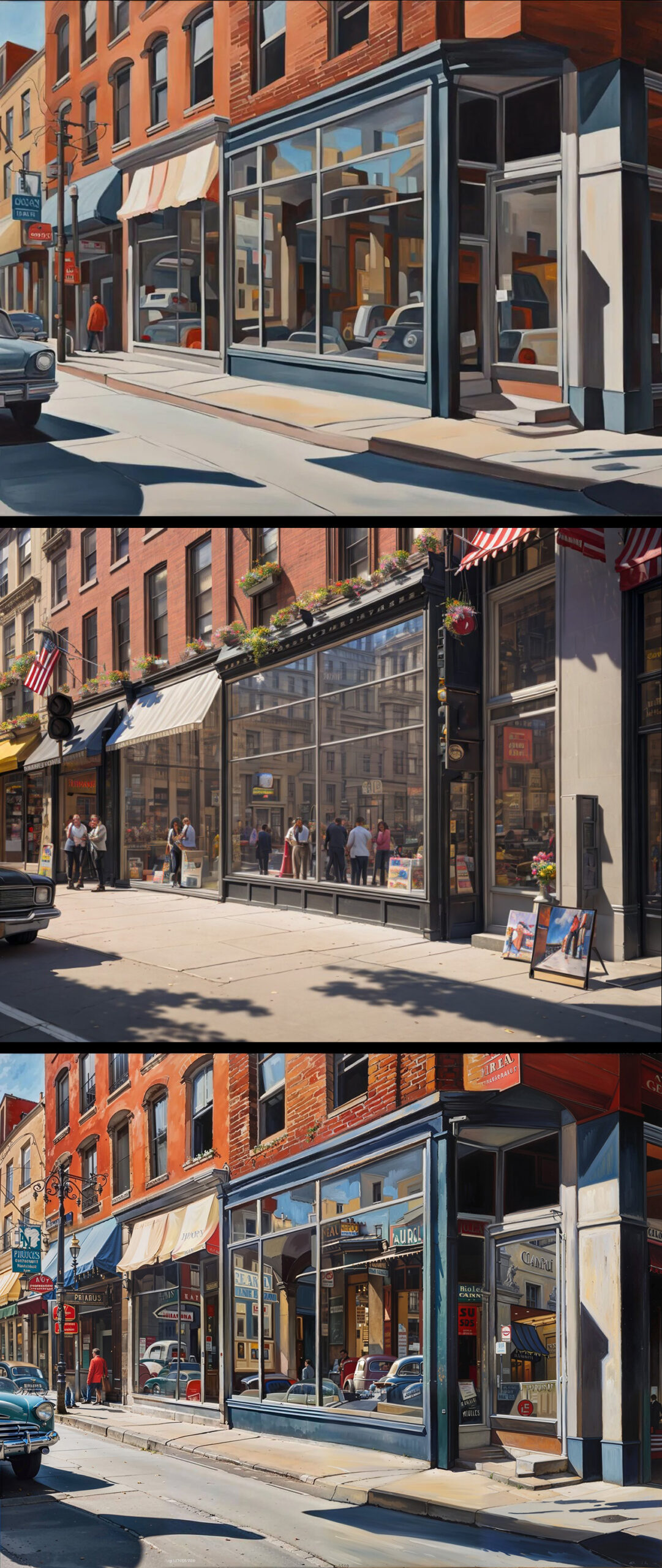

- Ein bereits per KI (NightCafe/Stable DiffusionXL)erzeugtes Bild, das in Deep Dream Generator mit dem Modell „Photonic“ bei 60% neu berechnet wurde. Zum Vergleich sehen Sie darunter eine mit Magnific.ai erstellte Version, das mein Kollege Olaf Giermann hier kürzlich vorgestellt hatte. Die Qualität ist nicht wesentlich besser, aber Magnific ist deutlich teurer.

- Ausgangsbild ist ein normales Foto eines kleinen Mädchens. Ich habe das Bild genau beschrieben und den Text dann als Prompt für die Bildvariationen verwendet. Je höher der Wert für „Effect strength“, um so eigenwilliger die Umsetzung.

- Was passiert aber, wenn man ein qualitativ sehr schlechtes Ausgangsbild hat? Das habe ich ausprobiert, indem ich das Foto durch ein paar Photoshop-Filter laufen ließ, so dass kaum noch erkennbare Details übrig blieben, dafür aber viele Artefakte entstanden. Bereits 40% Effekt strength führten zu brauchbaren Ergebnissen. Bei 90% unterscheidet sich das Resultat dann allerdings nur noch wenig von einer rein prompt-basierten Eingabe ohne Referenzbild.

- Ähnlich bin ich mit dem Foto eines Leuchtturms vorgegangen. Die Bildvariationen mit 60 und 90% führten zu sehr viel „schöneren“ Ergebnissen, hatten aber mit der Originalszene nur noch wenig zu tun. Erwartungsgemäß waren auch die rein prompt-basierten Bilder eindrucksvoll.

- Auch das Leuchtturm-Foto verschlechterte ich, diesmal, indem ich den Gaußschen Weichzeichner mit einer Stärke von 15 Pixeln anwandte. Noch bei 40% weist das Ergebnis Unschärfe auf; bei 60% ist es scharf – entsprechend frei interpretiert ist das Motiv.

- Was würde bei einem Foto entstehen, bei dem ich auf dem Kameradisplay nicht gesehen hatte, dass sich Regentropfen auf dem Objektiv niedergeschlagen hatten? Erst bei 40% – sowohl bei Deep Dream Generators Modellen Photonic als auch PhotoMage, verschwanden diese Tropfen, aber da sah das fotografierte Aquädukt auch schon ganz anders aus. Höhere Werte führten zu einer noch phantasievolleren Architektur.

- Schließlich wollte ich es ganz genau wissen und begann diesmal mit der groben Skizze eines Hundes auf einer Wiese, im Hintergrund Bäume, Berge und Himmel. Bei einer Schwarzweiß-Version der Grafik bedurfte es sehr hoher Werte mit entsprechend eigenwilligen Variationen. Besser wurde es bei einer farbigen Vorlage, aber noch bei 80% wirkte die Wiese sehr künstlich (vom fünften Bein mal ganz abgesehen). 90% führten schließlich zu einem sehr guten Resultat, das sich noch immer am Referenzbild orientierte – ohne dieses, nur mit Prompt, war die Ausrichtung des Hundes eine andere. Perfekt ist das noch nicht, Details wie Schlagschatten oder Schwanz sind – noch – nicht überzeugend.

Bild 3 | Selber Prompt, vergröbertes Original – evolve Photonic 40, 40, 60, 90% – nur Prompt ohne Referenzbild

Bild 4 | Prompt: »professional photo, a lighthouse with white and red horizontal stripes, dunes with some plants in the foreground, two small houses with red roofs in the dunes, blue sky with a few weak clouds« / Original – evolve Photoc 40, 60, 90% – nur Prompt ohne Referenzbild mit KI-Modell Photonic – mit KI-Modell AIVision

Bild 5 | selber Prompt, mit Gaußschem Weichzeichner mit 15 Pixel Radius gesoftetes Foto – evolve Photonic 20, 40, 60%

Bild 6 | « Prompt: »professional and detailed photo: a roman aqueduct in winter with a thin layer of snow, some bare trees, ruins in the foreground, dark weather« / Original – evolve Photonic 40% – evolve PhotoMage 40%

far away high mountains, blue sky with some clouds«

/ Original – evolve Photonic 80, 90% – nur Prompt ohne Referenzbild

Das Verfahren, in Deep Dream Generator Bildvariationen mit KI zu erzeugen, steht sicherlich erst am Anfang und bedarf weiterer Entwicklung. Aber schon jetzt kommen dabei ansehnliche Ergebnisse mit beeindruckendem Detailreichtum heraus, für die man bei einer „manuellen“ Montage sehr viel Arbeit aufwenden müsste. Wir dürfen auf die Zukunft dieser Funktion sehr gespannt sein.

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft: Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Diese mit vorgeblicher Intelligenz erzeugten Bilder haben natürlich nichts mit Fotografie zu tun. Oder nur so viel, dass sie vorhandene Fotos „abkupfern“ und nach einer Beschreibung oder einer Art von Skizze mehr oder weniger naturalistische Bilder erstellen. Damit macht die Software das, was seit Jahrhunderten oder Jahrtausenden je nach zur Verfügung stehender Ausrüstung Zeichner und Maler machen.

Allerdings mit dem großen Unterschied, dass die KI weder Intelligenz hat noch eigene Ideen produziert. Eigene Ideen zu haben, war auch bei Künstlern, also Zeichnern und Malern ein großes Problem, was natürlich genau so auf Musikschaffende, Autoren und andere produzierende Künstler gilt.

So lange das, was heute KI genannt wird, zum Teil auf erstaunliche Weise, doch immerhin eben __nur__, auf vorhandenes Material angewiesen ist, generiert sie nichts Neues.

Worüber wir Menschen froh und dankbar sein sollen. Denn wenn Machinen, Software, Robotor oder was auch immer tatsächlich Bewusstsein und Intelligenz erlangen, wird es Menschen ohnehin nicht mehr lange geben.

Nun – erstens habe ich gar nicht behauptet, KI-generierte Bilder seien Fotos; damit zu tun haben sie aber sicherlich. Sie sind zwar nicht durch einfallendes Licht zustande gekommen, aber wenn Betrachter, die die Entstehungsgeschichte nicht kennen, zwischen Foto und KI-Bild nicht mehr unterscheiden können, gibt es wohl schon gewisse Zusammenhänge.

In der Tat macht KI das, was Maler und Zeichner seit Jahrhunderten machen – aber ist das nicht ein guter Grund, sie zu bewundern?

Auch wenn sie keine Intelligenz „haben“, so simulieren sie doch intelligente Leistungen oft recht überzeugend. Die „eigenen Ideen“ liefert natürlich derjenige, der den Prompt formuliert, und ich bin immer wieder von den Ergebnissen dieser Umsetzungen fasziniert – was das „Konzept“, die Komposition, die Details und die technische Ausführung betrifft. Und ich fürchte, recht viele „Künstler“ könnten da kaum mithalten; es gibt ja nicht nur die weltberühmten „Genies“.

Ebenso gibt es wenige Künstler, deren Werke nicht ebenso auf „vorhandenes Material“ zurückzuführen sind und die „nur“ für dessen Neuanordnung sorgen. Ein gutes Beispiel ist Greg Rutkowski, der sich – verständlich – über den KI-Klau seines Stils ärgert, aber selbst ohne Vorbilder wie Frazetta, Vallejo oder die Brothers Hildebrandt kaum denkbar wäre. Grundlegend „Neues“ gibt es doch in der Kunst ziemlich selten.

Was den letzten Satz betrifft: Ja, kann durchaus sein, dass es uns Menschen dann nicht mehr lange geben könnte. Aber mal ehrlich: Brauchen wir dafür die KI? Wir tun doch schon mit unserer natürlichen Intelligenz alles, um das so schnell wie möglich zu erreichen. Was jenseits der überschaubaren Wahlperioden und Jahresbilanzen stattfindet, ist doch praktisch uninteressant.

Das mit dem „Bewundern“ ist wohl eher das Erstaunen über Möglichkeiten, die Software leisten können. Doch das gibt sich, wenn diese Leistungen alltäglich werden. In jeder Generation der technischen Entwicklungen der letzten Jahrhunderte gab es neue Erfindungen, die Leute staunen und bewundern ließen. Menschen haben schon immer Werkzeuge erdacht, genutzt, verbessert und zu ihrem Vorteil eingesetzt. Dabei ging es immer darum Leistungen zu erbringen, für die der eigene Körper nicht ausreichte. Das Rad brachte Geschwindigkeitsvorteile, Maschinen konnten schneller und kräftiger Aufgaben erledigen.

So war es eben auch mit Computern. Die Geschwindigkeit von Rechenoperationen war erstaunlich, auch sie wurde „bewundert“. Ist heute ein alter Hut, derzeit ist KI „in“, wobei die darin enthaltene Intelligenz so modifiziert wurde, dass sie mit dem ursprunglichen Begriff „Intelligenz“ nicht viel gemein hat, ist eher ein Missbrauch des Begriffs, etwas, das besonders im Bereich Marketing sehr beliebt ist.

Das, was diverse „KI“-Programme heutzutage liefern, haben Quassler und „Künstler“ schon immer gemacht. Nur können das eben Computer viel schneller und in einem Umfang, der den vorgegebenen Anweisungen entspricht. Da die Software von einigermaßen intelligenten Menschen entwickelt und laufend verbessert wird, sind die Ergebnisse nicht übel, doch allein wegen der riesigen Menge an Output in ihrer Wahrheit nicht einzuordnen. Ergebnisse können nützlich sein, viele sind jedoch eher das Gegenteil davon.

Nur werden wir mit all diesen Fake-Outputs leben müssen, doch da eine Reglementierung aussichtslos ist, kommt auch keine Bewunderung auf.

Ich habe gerade den Text überflogen. Für mich stellt sich die Frage, ob man auch eigene Bilder bearbeiten kann? Also quasi eine Melange zwischen Fotograf und KI. Wenn ja wäre es natürlich ein neuer kreativer Ausgangspunkt zur Verfremdung eigener Bilder.

Mitunter kann es ganz hilfreich sein, einen Artikel zu lesen und erst dann eine Frage zu stellen 🙂 . Alle von mir verwendeten Ausgangsbilder sind eigene Fotos.

Mea culpa – Wenn ich den Artikel gründlich gelesen habe werde ichs mal ausprobieren.