Analoge und digitale Fotografie

Seit rund zwei Jahrzehnten bedeutet Fotografie vor allem Digitalfotografie, auch wenn noch immer Filme und vor allem Sofortbildmaterial belichtet werden. Was aber hat sich durch den Wechsel von der analogen zur digitalen Technologie eigentlich verändert?

Na klar, in der Digitalfotografie werden Farbe und Helligkeit durch Zahlenwerte wiedergegeben – eben digital. Analog bedeutet dagegen, dass eine physikalische Größe durch eine andere repräsentiert wird. Die Höhe der Quecksilbersäule eines analogen Thermometers entspricht der Höhe der Temperatur. Eine Umdrehung des Stundenzeigers einer analogen Uhr entspricht einer halben Erdumdrehung. Bei einem analogen Synthesizer entsprechen 1 Volt mehr oder weniger einem um eine Oktave höheren oder niedrigeren Ton. Und so weiter. Was ist nun in der Silberhalogenidfotografie das Analogon zu Farben und Helligkeiten?

Eine schwarzweiße Filmemulsion enthält nach der Entwicklung feinste Silberkristalle, eine Farbfilmemulsion kleine Farbwölkchen in den Grundfarben. Ein lichtundurchlässiger Silberkristall ist aber entweder da oder nicht da; es gibt kein halb- oder vierteldurchlässiges Silber und daher keine Abstufungen. Auch die Farbstoffwölkchen gibt es nur in den Grundfarben, ohne weitere Varianten des Farbtons oder der Lichtdurchlässigkeit. Die feinen Abstufungen von Tonwerten und Farbtönen entstehen erst durch ein Dithermuster dieser Partikel. Die zu Farbe und Helligkeit analoge Größe ist daher die Dichte der Partikel, also wie viele Silberkristalle oder Farbstoffwölkchen jeder der Grundfarben es in einer gegebenen Fläche gibt. Aber wie groß sollte diese Fläche sein?

Wenn man ein relativ grobes Raster über ein Bild eines Farbfilms legt und in jedem Rasterfeld die Farbstoffwölkchen auszählt, ermittelt man ein breites Spektrum unterschiedlicher Zahlen und kann also Farben und Helligkeiten fein auflösen. Dagegen ist die Ortsauflösung aufgrund des groben Rasters gering. Verwendet man ein feineres Raster, steigt die Ortsauflösung, aber da man in den kleineren Feldern weniger Farbstoffwölkchen zählt, geht dies auf Kosten der Farb- und Helligkeitsauflösung. Im Extremfall findet man in extrem kleinen Rasterfeldern nur noch entweder ein oder kein Farbstoffwölkchen, so dass es gar keine Zwischenwerte mehr gibt. Dabei geht es immer um dasselbe Bild, aber ein wie großes Raster sollen wir nun darüber legen, um seine Auflösung zu bestimmen? Es gibt nicht die eine, einzig richtige Rastergröße, und so ist die Auflösung von Filmmaterial nicht eindeutig definiert.

Beim Digitalbild sind die Verhältnisse vergleichsweise einfach und eindeutig. Die Zahl der Sensorpixel bestimmt die Ortsauflösung und die Farb- und Helligkeitsauflösung hängt davon ab, wie viele Bits aus jedem Sensorpixel ausgelesen werden. Da die Pixel typischer Sensoren unter Farbfiltern im Bayer- oder X-Trans-Muster liegen und vollständige Farbwerte durch eine Interpolation aus Nachbarpixeln gewonnen werden müssen, entspricht die effektive Ortsauflösung allerdings nur etwa der Hälfte der Pixelzahl des Sensors.

Ob solche Feinheiten in der Praxis einen Unterschied machen, hängt davon ab, wie nahe wir den Bilddetails kommen. Aus einem normalen Betrachtungsabstand ist die unterschiedliche Abbildungsweise analoger und digitaler Verfahren nicht offensichtlich.

Für den Fotografen ist ein anderer Unterschied viel wichtiger: Während der Film eine nicht zu starke Überbelichtung recht gut wegsteckt – die sehr dichten Negative erfordern dann nur eine längere Belichtungszeit, wenn man sie vergrößert –, aber Unterbelichtung kaum verzeiht, ist es beim Sensor gerade umgekehrt. Unterbelichtete Bilder lassen sich im Raw-Konverter leicht um mehrere Blendenstufen aufhellen und bewahren dabei auch noch die Lichterzeichnung besser; das mit der Schattenzeichnung hervorgeholte Rauschen bekommt man mit modernen Rauschunterdrückungsverfahren gut in den Griff. Überbelichtungen gehen dagegen schnell auf Kosten des Dynamikumfangs. Wenn in den letzten Jahren so oft die Maxime ETTR (Expose To The Right) gepredigt wurde, dann eben deshalb, weil sie für altgediente Fotografen ungewohnt war – Negativfilme profitieren von Expose To The Left, also einer Belichtung auf die Schatten, und wer zur Digitalfotografie wechselte, musste umdenken.

Es gibt aber noch einen weiteren Unterschied, an den man zuerst vielleicht gar nicht denkt. In der analogen Fotografie, die Sofortbildfotografie einmal ausgenommen, hat der fotografische Prozess immer zwei Teile. Zunächst belichtet man den Film in der Kamera, dann werden in einem zweiten Schritt der Film entwickelt und die Negative auf Fotopapier vergrößert. Die Digitalfotografie hat auch diesen zweiten Schritt in die Kamera verlagert, denn gespeicherte JPEGs sind fertige Bilder, die gegebenenfalls nur noch auf Papier geprintet werden müssten. Dies hat dazu geführt, dass die Bildverarbeitung von den rohen Sensordaten bis zum entwickelten RGB-Bild, also das, was der Volksmund JPEG-Engine nennt, in ihrer Bedeutung unterschätzt wird. Man drückt auf den Auslöser und sieht Sekundenbruchteile später ein fertiges Bild – was kann also schon groß dabei sein? Demjenigen, der seine Fotos im eigenen Labor entwickelte und vergrößerte, war hingegen wohl bewusst, wie viele Möglichkeiten die zweite Hälfte der Fotografie noch bietet, und konnte sie gezielt nutzen.

Dass immer noch viele Digitalfotografen einen Raw-Workflow scheuen, hängt vielleicht damit zusammen. Man macht sich nicht klar, dass immer eine Raw-Entwicklung stattfindet, denn die JPEG-Engine ist ja nichts anderes als ein Raw-Konverter. Heutzutage erlauben es die meisten Kamerahersteller, diesen eingebauten Raw-Konverter auch noch nachträglich zu starten, um gespeicherte Raw-Dateien mit alternativen Parametern zu entwickeln – und sei es nur, um einen falschen Weißabgleich zu korrigieren, denn auch dieser fällt ja in die zweite Phase der Fotografie (in der analogen Dunkelkammer nahm man den Weißabgleich beim Vergrößern vor, was etwas mühsam war).

Manche schwören auf Canon-, Fuji-, Leica- oder Nikon-Farben, obwohl es dabei nur um die Abstimmung der JPEG-Engine geht. Die könnte man aber auch selbst vornehmen, indem man die Parameter der Raw-Entwicklung in die eigene Hand nimmt, ob nun beim Raw-Konverter in der Kamera oder im Computer. Wobei der Raw-Konverter auf dem Computer mehr Funktionen bietet und bequemer bedienbar ist, schon weil man zur Beurteilung des Bildes nicht auf das Mäusekino der Kamera angewiesen ist. Die digitale Technologie hat den zweiten Teil der Fotografie noch viel einfacher gemacht, als er in der analogen Ära jemals war; man hat viel mehr Eingriffsmöglichkeiten, muss nicht mehr im Dunkeln arbeiten und keine Chemikaliendämpfe einatmen. Nun muss man diese Chance nur noch nutzen.

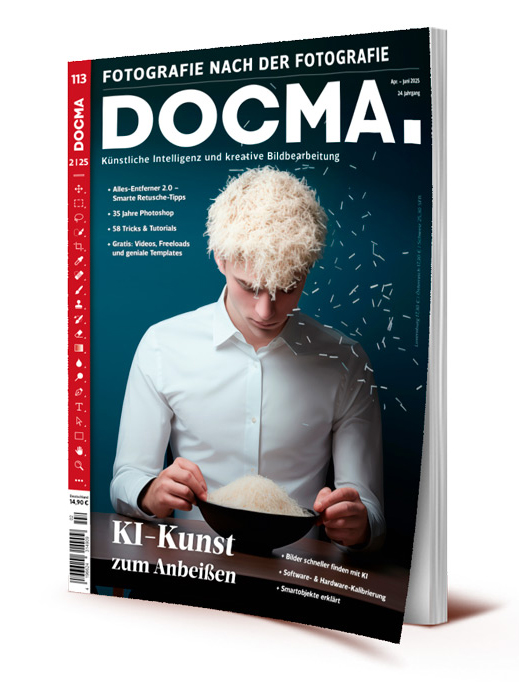

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft: Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Schöner Artikel, der die Grundsätze und Unterschiede der analogen und digitalen Fotografie kompakt und verständlich beschreibt. Manche schwafeln über das Thema über Bücher hinweg. Aber bei einer Bemerkung hatte ich bei duchlesen doch gestoppt: „Eine Umdrehung des Stundenzeigers einer analogen Uhr entspricht einer halben Erdumdrehung.“ Stimmt das so ? :-)…….

Die Erde braucht 24 Stunden für eine Umdrehung, der Stundenzeiger nur 12 Stunden; analoge Uhren mit 24-Stunden-Zifferblatt haben sich nicht durchgesetzt.