Lightroom: Wie kann man »Details verbessern« verbessern?

Vor einem Jahr hat Adobe die Funktion »Details verbessern« in Lightroom Classic und Camera Raw eingeführt. Wie viel diese Funktion in der Praxis der Raw-Konvertierung bringt, ist umstritten, und ihre Funktionsweise ist auch nicht jedem klar. Wie kann man den größten Nutzen daraus ziehen, ohne seinen Workflow in größerem Maße umzustellen?

Am Anfang der Raw-Entwicklungs-Pipeline steht das sogenannte Demosaicing, das aus den Rohdaten erst ein RGB-Bild erzeugt. Die Pixel fast aller Sensoren – nur die Foveon-X3-Sensoren von Sigma bilden eine Ausnahme – sind nur für jeweils eine der Grundfarben Rot, Grün und Blau empfindlich. Die Rohdaten liefern also zu jedem Pixel nur die Helligkeit in einem Farbkanal; die fehlenden zwei Drittel eines vollständigen RGB-Pixels müssen geschickt erraten werden. Immerhin gibt es jeweils Nachbarpixel, die für die fehlenden Grundfarben empfindlich sind, und aus diesen kann man die fehlenden Informationen zu interpolieren versuchen. Die Verfahren des Demosaicing sind in den letzten 25 Jahren immer weiter verbessert worden, aber auch die besten algorithmischen Verfahren gehen gelegentlich in die Irre, und das Ergebnis sind dann Artefakte. Insbesondere in Bildbereichen mit feinen Details errät das Demosaicing oft falsche oder zu wenig gesättigte Farben. Auch das gefürchtete Farbmoiré ist nichts anderes als ein Demosaicing-Fehler. Sensoren ohne Tiefpassfilter sind besonders anfällig für solche Artefakte, denn sie registrieren zwar kontrastreichere Details, liefern aber nicht mehr Farbinformationen als Sensoren mit einem solchen, die Auflösung begrenzenden Filter, und der Versuch, aus den Sensordaten hoch aufgelöste und kontrastreiche Farbbilder zu berechnen, ist dann besonders fehleranfällig.

Adobe hat nun ein völlig neues, KI-basiertes Demosaicing-Verfahren entwickelt, das mit einem neuronalen Netz arbeitet. Neuronale Netze werden nicht programmiert, sondern mit einem Lernverfahren entwickelt. Adobe stellte einen Korpus von Bildern mit besonders problematischen Details zusammen, die klassische Demosaicing-Verfahren herausfordern, und trainierte damit das neuronale Netz, bis es jeweils die optimale Rekonstruktion der RGB-Daten gefunden hatte. Genau genommen sind es zwei Netze, denn Adobe entwickelte auf diesem Wege unterschiedliche Verfahren für Sensoren mit dem verbreiteten Bayer-Farbfiltermuster und für Fujis-Sensoren mit dem komplexeren X-Trans-Muster.

Um den Unterschied zwischen dem KI- und dem klassischen Demosaicing zu sehen, muss man zwar genau hinschauen – es geht nun mal um die Details, und diese zeigen sich erst, wenn man weit in das Bild hinein zoomt –, aber die Verbesserung kann dennoch erheblich sein. Jim Kasson hat die teils eindrucksvollen Resultate in einer Serie von Artikeln in seinem Blog dokumentiert. Wie Rico Pfirstinger jüngst in einem umfangreichen Vergleich gezeigt hat, erzeugt »Details verbessern« zumindest bei niedrigen ISO-Werten und daher rauscharmen Bildern eine noch ein wenig bessere Detailzeichnung als der bisherige Königsweg zu artefaktfreien Bildern – nämlich eine Kamera mit höherer Sensorauflösung zu wählen und deren Bilder am Ende auf eine niedrigere – in diesem Fall halbe – Auflösung herunterzurechnen. Auch das oft für überlegen gehaltene Capture One kann hier nicht mithalten. Erst bei stärker verrauschten Bildern verfängt die KI dann immer weniger, wie Rico Pfirstinger herausgefunden hat, während das Oversampling mit einem höher auflösenden Sensor weiterhin Vorteile bringt. Da Sie die Dienste der KI, anders als eine höher auflösende Kamera, nichts kostet, ist sie in jedem Fall einen Versuch wert.

Nun hätte man dieses neue, KI-basierte Demosaicing-Verfahren als Basis eines neuen Prozesses nehmen können, aber dem stand ein Problem entgegen: Das neuronale Netz benötigt für das Demosaicing sehr viel mehr Zeit als die bisher üblichen Verfahren, und der neue Prozess würde zwar Bilder mit feineren, naturgetreueren Details produzieren, dabei aber dem Anwender viel Geduld abverlangen. Wann immer man eine Entwicklungseinstellung ändert, muss das Bild schließlich neu berechnet werden, und das würde unzumutbar lange dauern.

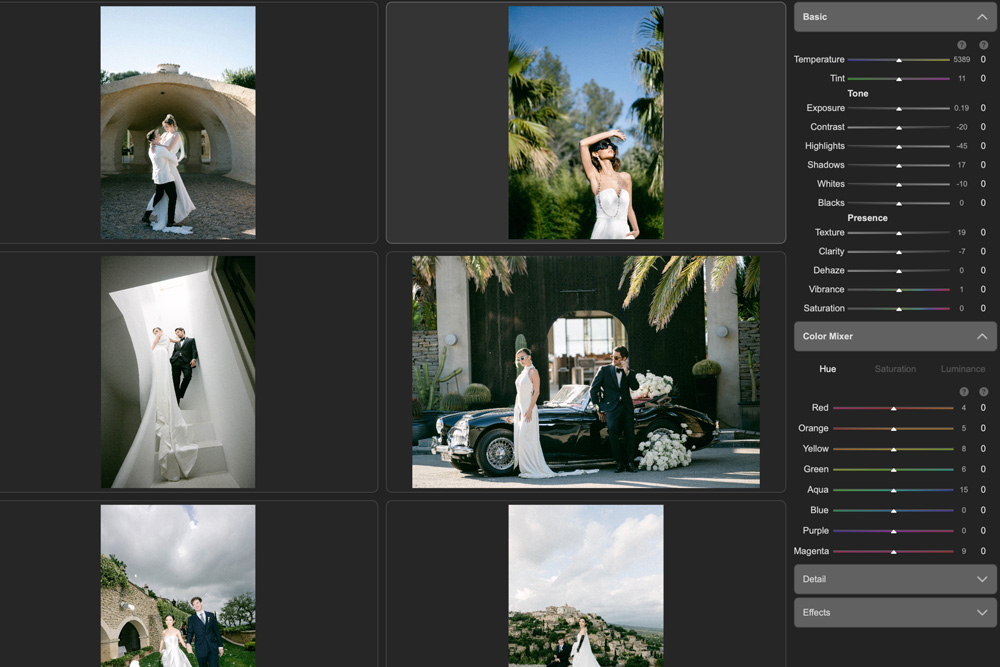

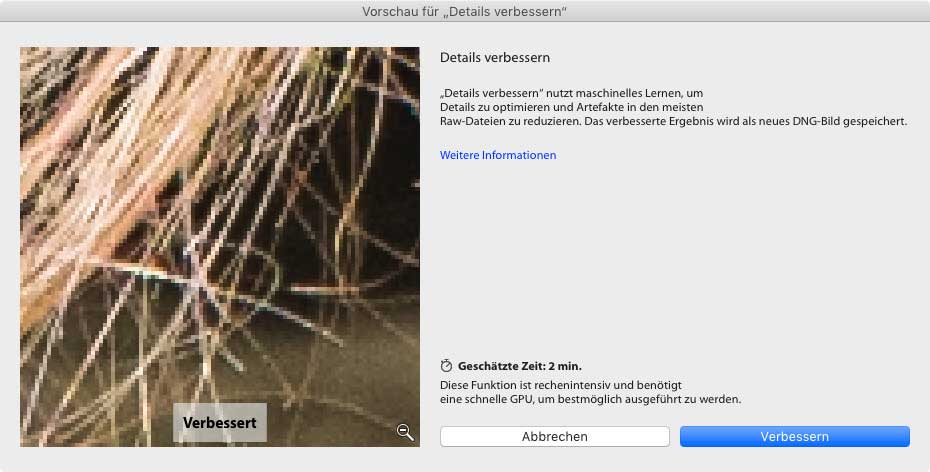

Adobes Lösung besteht darin, es zunächst einmal beim bewährten Verfahren zu belassen und das KI-gestützte Demosaicing als zusätzliche Funktion anzubieten. Wenn Sie im Entwickeln-Modul »Foto > Details verbessern« aufrufen, wird das neuronale Netz auf die Rohdaten der aktuellen Aufnahme angewandt und eine DNG-Datei erzeugt, die ein RGB-Bild im Linear-Raw-Format mit 16 Bit pro Kanal enthält. Je nach dem Leistungsvermögen Ihres Computers – insbesondere von dessen Grafikchip, auf den die Berechnungen ausgelagert werden –, kann das dann einige Zeit dauern. Obwohl die so erzeugte DNG-Datei verlustfrei komprimiert ist, benötigt sie leider ein Vielfaches des Speicherplatzes der originalen Raw-Datei. Das liegt vor allem daran, dass 48 statt (meist) 14 Bit pro Pixel enthalten sind, aber Lightroom fügt auch noch die nicht-demosaicten Rohdaten hinzu – was im Grunde unnötig ist, denn wenn Sie damit arbeiten wollen, steht Ihnen ja die Originaldatei weiter zur Verfügung.

Auf das lineare (demosaicte) Raw in der so berechneten DNG-Datei lassen sich dann alle gewohnten Entwicklungseinstellungen anwenden, und die Berechnungen erfolgen mit der gewohnten Geschwindigkeit, da das Demosaicing ja schon erledigt ist. Sie können sich die DNG-Datei als eine Art Cache-Speicher für das aufwendige Demosaicing per KI vorstellen, der es erspart, diese aufwendige Berechnung immer wieder neu auszuführen.

Dennoch würde Ihr Raw-Workflow immer noch deutlich ausgebremst, wenn Sie nach dem Import Ihrer Aufnahmen erst einmal auf alle Bilder »Details verbessern« anwenden müssten. Empfehlenswerter ist eine andere Vorgehensweise: Arbeiten Sie einfach weiter wie gewohnt und wählen Sie zunächst die Entwicklungseinstellungen, die Ihre Aufnahme am besten zur Geltung bringen. Erst wenn Sie dann beim Blick auf die Details in 100% feststellen, dass es hier Verbesserungspotential gibt, und Sie das Bild in einer Weise präsentieren wollen, dass es auf die feinsten Details ankommt, dann rufen Sie »Foto > Details verbessern« auf. Die DNG-Datei übernimmt Ihre Entwicklungseinstellungen, so dass Sie das verbesserte Bild nur noch zu exportieren brauchen. Wenn es Sie stört, dass die DNG-Datei so viel Speicher belegt – dabei kommen durchweg 100 Megabyte und mehr zusammen –, können Sie diese nach dem Export bedenkenlos löschen, da sie sich notfalls jederzeit neu berechnen lässt. Die KI hinter »Details verbessern« ist ohnehin ein work in progress und es ist damit zu rechnen, dass künftige Versionen noch bessere Ergebnisse bringen werden. Um diese dann zu nutzen, ist ohnehin eine Neuberechnung nötig.

Es bleibt zu hoffen, dass sich das Demosaicing mit KI irgendwann so stark beschleunigen lässt, sei es durch eine Optimierung der Software oder durch schnelle CPUs und GPUs, dass es Eingang in einen neuen Prozess finden kann. Falls das nicht so bald gelingt, bliebe Adobe noch eine andere Option. Mein Vorschlag zur Güte wäre, eine Art Lazy-Details-verbessern einzuführen. Unter lazy execution versteht der Informatiker, dass Berechnungen nicht sofort ausgeführt, sondern nur für eine spätere Ausführung vorgemerkt werden – spätestens dann, wenn das Ergebnis wirklich benötigt wird. Das könnte dann so aussehen: In einem Panel des Entwicklungs-Moduls setzen Sie für eine Aufnahme ein Häkchen bei einer Option „Details verbessern“. Lightroom würde nun aber nicht gleich in hektische Aktivität verfallen und Sie zum Däumchendrehen zwingen. Das Zwischen-DNG könnte irgendwann im Hintergrund berechnet werden, während sonst gerade nichts zu tun ist, oder sobald der Export gestartet wird. Wenn Sie den Speicherverbrauch durch die DNG-Dateien fürchten, könnten Sie Lightroom so konfigurieren, dass Zwischen-DNGs nach einer bestimmten Zeit automatisch gelöscht werden. Oder Sie geben vor, wie viel Speicher diese DNGs belegen dürften – wenn dieser überschritten wird, löscht Lightroom selbsttätig das älteste DNG. Und wenn Sie ein gelöschtes DNG doch noch einmal brauchen, wird es eben on-the-fly neu berechnet.

Fazit

Adobes KI-gestütztes Demosaicing-Verfahren »Details verbessern« wird vermutlich noch weiter verbessert werden, aber es funktioniert schon jetzt so gut, dass man sich wünschen würde, dass es das klassische Verfahren vollständig ersetzt. Dem steht derzeit noch der hohe Rechenaufwand entgegen, aber Adobe könnte es den Anwendern mit kleinen Änderungen einfacher machen, diese Funktion in ihren Workflow zu integrieren. Wenn man es geschickt anstellt, »Details verbessern« erst zum Schluss und nur bei Bedarf anwendet und die dabei erzeugten DNG-Dateien gegebenenfalls löscht, nachdem sie ihre Rolle gespielt haben, sind die Kosten – Rechenzeit und Speicherplatz – auch heute schon kein Grund, auf diese Verbesserung der Bildqualität zu verzichten.