Vor ein paar Tagen schicke ein Kollege Doc Baumann einen Link über Verbote KI-generierter Bilder, und der fürchtete sofort erweiterte Zensurmaßnahmen, als er las: „Adobe Stock aktualisiert Richtlinien für Missbrauch von irreführenden Kriegsbildern“. Aha, dachte er, erst kriegt Firefly einen virtuellen Schreikrampf, wenn man ein paar Quadratzentimeter nackter Haut darstellen möchte, und nun folgen weitere Einschränkungen, was man darf und was nicht. Aber da hatte er den Text von Adobe noch nicht gelesen …

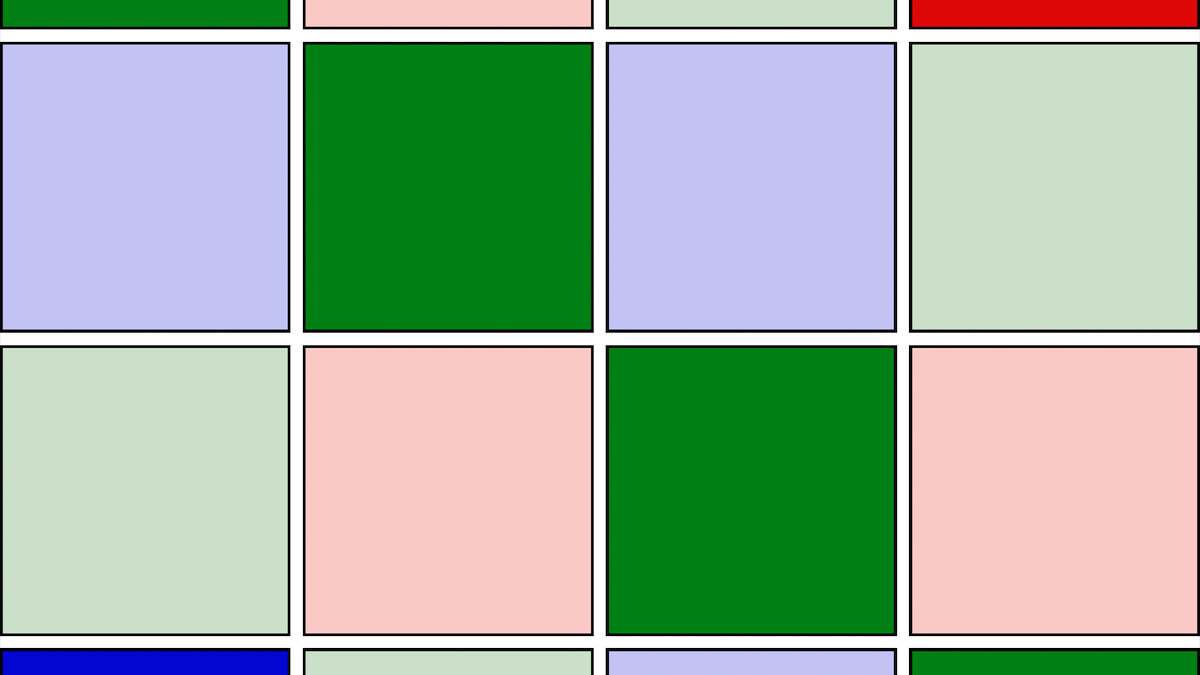

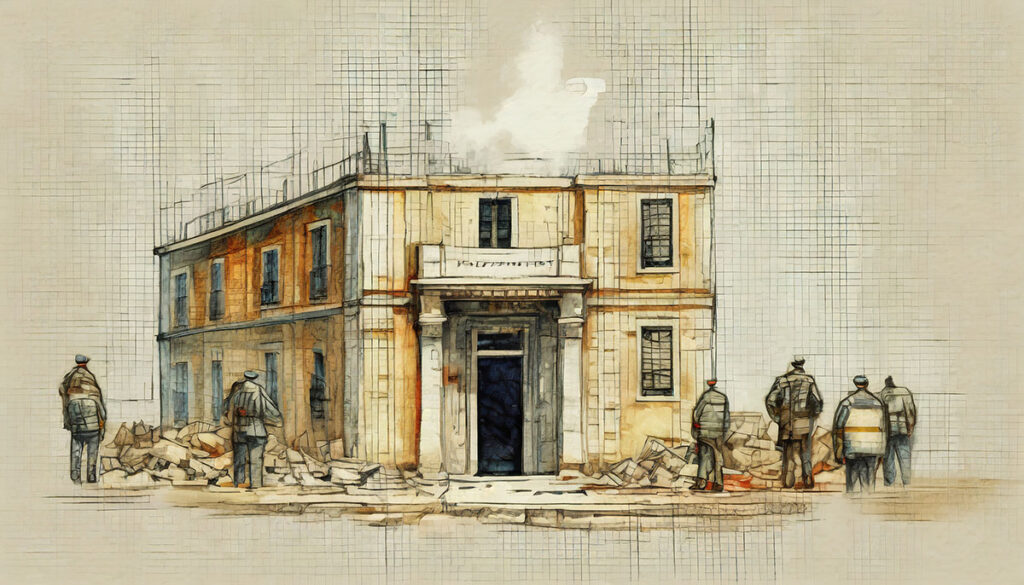

Ausgelöst durch KI-generierte Bilder zum Gaza-Krieg, die als solche nicht gekennzeichnet waren und Betrachtern daher als authentische Fotos erscheinen mussten, entstand eine Diskussion darüber, wie mit solchen Bilder umgegangen werden sollte. | Illustration: Doc Baumann mit Adobe Fiurefly. Prompt: »Professionelles Reportagefoto, ein großer Krater in einer Straße durch eine Explosion, ringsum zerstörte Betonbauten, viele Menschen in orientalischer Kleidung, die in den Krater blicken, Trümmer, Schutt, aufsteigender Rauch, Orient«. Auf die Retusche von Unstimmigkeiten (etwa Dreibein) habe ich verzichtet.

Für mich signalisierte dieser Link umgehend weitere Einschränkungen und Zensurmaßnahmen. Derzeit wird ja überall darüber diskutiert, dass KI gefährlich sein oder werden könnte, und dass man solchen Entwicklungen durch geeignete Rahmenbedingungen rechtzeitig vorbeugen müsse. Das ist generell sicherlich richtig und entsprechende Maßnahmen sind daher zu begrüßen und zu unterstützen. Aber ich dachte natürlich sofort an das, was uns die meisten KI-Bild-Plattformen verbieten wollen – dabei gibt es für die Welt sicherlich gravierendere Gefahren als jene, die von nackten Brüsten ausgehen könnten. Zumal der erwartbare nächste Schritt dann ohnehin darin besteht, dass Plattformen entstehen, die sich auf genau so etwas spezialisieren (und es wie pornpen.ai auch recht gut umsetzen). Das ist bei Nacktheit unproblematisch – aber nicht, wenn es um das Zusammenmischen von Sprengstoffen geht oder die Züchtung von Killerviren.

Man stelle sich vor, Adobe oder andere Hersteller würden in ihre Bildbearbeitungssoftware kleine Spione einbauen – mit KI sicherlich kein Problem –, die sofort Alarm schlagen, wenn an einem Bild gearbeitet wird, das irgendwelchen US-Zensoren moralisierende Bauchschmerzen bereitet. Grundsätzlich gibt es so etwas ja schon, wie jeder weiß, der schon einmal versucht hat, den Scan eines Geldscheins zu verwenden. Da schüttelt Photoshop empört mit dem Kopf und verweigert die Arbeit.

Oder man stelle sich vor, dergleichen würde einem mit einer Textverarbeitungssoftware passieren. Ob nun ein Jünger von Stephen King das blutige Finale einer Horrorgeschichte beschreiben will oder jemand, der den BDS-Boykott gegen Israel für richtig hält, dafür eine Rechtfertigung verfasst – umgehend ploppt am Monitor ein Warnfenster auf und verkündet, diese Zeilen verstießen gegen die Nutzungsrichtlinien der Software. Wenn der gern missbrauchte Begriff „Tugendterror“ irgendwo angemessen wäre, dann hier. Wobei sich mir nicht erschließt, wo sich hier die Tugend verbirgt. Zum Glück gibt es das bei Textprogrammen (noch) nicht. Und bei Adobe? Was ist denn nun von der aktuellen Ankündigung zu erwarten?

Also öffnete ich erst mal den Link, um nachzuschauen, ob meine Befürchtungen angemessen sind. Der Text stammt von Matt Smith von Adobe, und wie ich gleich feststellte, geht es gar nicht direkt um Firefly (steht so ja auch im Link), sondern um Adobe Stock. Nach einigen einleitenden Zeilen schreibt Smith unter anderem (hier ins Deutsche übersetzt):

„Mit steigender Nachfrage nach Inhalten mussten sich Stock-Contributors beeilen, den wachsenden Bedarf an solchen Assets zu decken, und für viele hat sich generative KI als entscheidender Schlüssel erwiesen. Unsere Stock-Contributors haben festgestellt, dass generative KI ein sehr erfolgreiches Werkzeug ist, um am Stock-Marktplatz teilzunehmen.

Aber ich möchte klarstellen: Adobe Stock-Content ist kein realweltlicher journalistischer Inhalt und sollte niemals in journalistischen Medien verwendet werden, um aktuelle Ereignisse darzustellen.

Obwohl jeglicher digitaler Inhalt verändert werden kann, um Menschen zu täuschen, hat generative KI das Potenzial, es für böswillige Akteure einfacher zu machen, Bilder zu erstellen, die täuschen. Das hat uns dazu veranlasst, unsere Herangehensweise an die Zulassung von generativem KI-Content auf Adobe Stock sorgfältig zu überdenken, einschließlich der Anforderung, dass Contributors jeden generativen KI-Content, den sie einreichen, als solchen kennzeichnen, damit Kunden generative KI-Inhalte anzeigen und filtern können. Deshalb hat Adobe proaktive Maßnahmen ergriffen, um das Vertrauen in digitalen Inhalt durch die von Adobe geleitete Content Authenticity Initiative (CAI) wiederherzustellen. Diese ermöglicht es Erstellern, wichtige Informationen an ein Bild anzuhängen, wie beispielsweise den Ursprung und die Art der Erstellung, damit Menschen eine informierte Entscheidung darüber treffen können, ob sie darauf vertrauen wollen.

Ob generative KI oder nicht, wir wissen, dass dasselbe Stock-Bild, das angemessen verwendet werden kann, beispielsweise auf dem Cover eines Buches oder in einem Videospiel, auch missbraucht werden kann, um Menschen zu täuschen. Aus dem Kontext genommen, hat digitaler Inhalt das Potenzial, Schaden anzurichten; das ist eine bedauerliche Realität, die sich in laufenden Konflikten auf der ganzen Welt abspielt …“

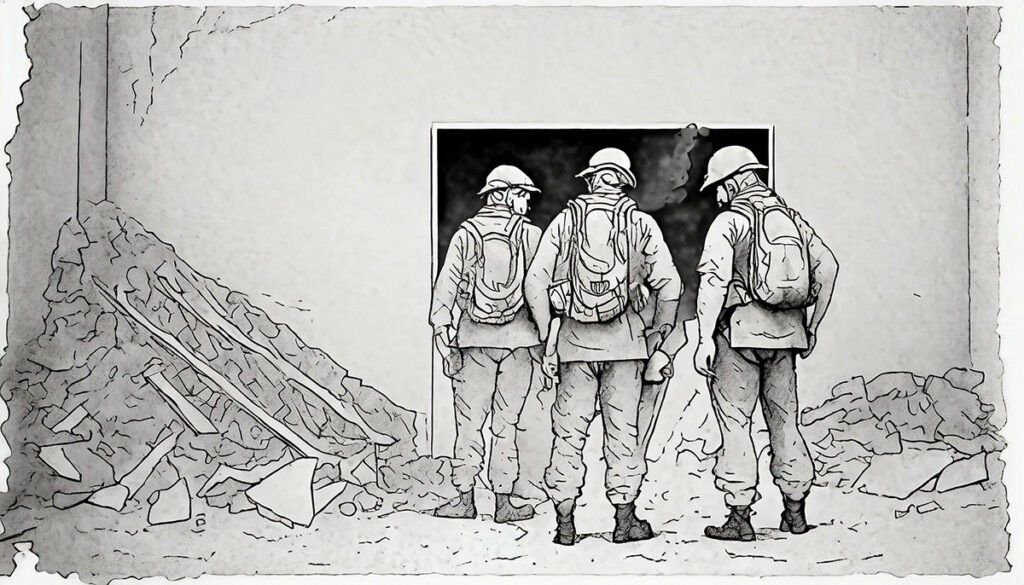

Dass es sich um eine (künstlerische) Interpretation handelt und nicht um die Wiedergabe einer realen Szene, wird für Betrachter transparent, wenn das Bild den Charakter einer als solche erkennbaren Illustration hat. | Doc Baumann mit Firefly. Der Prompt:„»Professionelles Reportagefoto, mehrere bewaffnete Soldaten in israelischen Uniformen stehen zwischen Schutt und Trümmern und schauen in einen Tunneleingang am Boden« wurde wegen „bewaffnet“ zurückgewiesen, ebenso wie „Uzis“ oder „Spielzeuggewehre“. Ohne „bewaffnet“ klappte es dann. Trotz zahlreicher Versuche und Neuformulierungen gelang es mir übrigens nicht, einen Tunneleingang/Schacht am Boden darzustellen. DALL·E 3 verweigerte die Umsetzung des Prompts gänzlich.

Daraus ergeben sich für Adobe-Stock-Richtlinien folgende Konsequenzen:

Aktualisierung unserer Einreichungsrichtlinien: Beitragende dürfen keinen generativen KI-Content einreichen, dessen Titel darauf hindeutet, dass er ein tatsächliches berichtenswertes Ereignis darstellt. Wenn ein Contributor generativen KI-Content falsch betitelt, werden wir dies überprüfen und angemessene Maßnahmen ergreifen, einschließlich der Entfernung des Inhalts oder der Kündigung des Contributor-Kontos.

Aktualisierung unserer Nutzungsrichtlinien: Es wird klargestellt, dass redaktionelle Verwendungen von Adobe Stock-Content nicht dazu verwendet werden dürfen, zu täuschen oder irrefzuühren, und dass dies einen Verstoß gegen unsere Nutzungsbedingungen darstellt. Stock-Content sollte immer klar gekennzeichnet sein, wenn er in redaktionellen Inhalten verwendet wird, um sicherzustellen, dass Menschen nicht in die Irre geführt werden und denken, dass ein echtes Ereignis durch den Stock-Content dargestellt würde. Wenn ein Verlag oder ein anderer Lizenznehmer ein klar gekennzeichnetes Stock-Asset in irreführender Weise verwendet, um Menschen zu täuschen, werden wir dies überprüfen und angemessene Maßnahmen ergreifen, einschließlich der Beendigung ihrer Rechte an diesem Stock-Asset.

Klarere Kennzeichnung von Bildern, die mit generativer Technologie erstellt wurden: Heute identifiziert Adobe bereits generative KI-Bilder, aber wir sind entschlossen, es Menschen leichter zu machen, zu erkennen, welche Bilder mit generativer KI erstellt wurden, bevor sie sie auf Adobe Stock lizenzieren.

Anzeigen von Content Credentials bei Stock-Bildern, bei denen generative KI verwendet wurde.“

Wie gut, dachte ich, dass die Initiative nicht „Content Initiative Authenticity“ heißt … Aber ich muss gestehen, dass ich bei aller Abneigung gegen gewisse moralisierende KI-Einschränkungen etwa von Adobe an diesem Text von Matt Smith überhaupt nichts auszusetzen habe. Die hier beschriebenen Maßnahmen finde ich richtig und sinnvoll. Täuschung der Betrachter setzt ja nicht mit der Produktion solcher Bilder ein, sondern mit ihrer Verwendung und der impliziten oder gar expliziten Beschreibung, der Bildinhalt sei authentisch.

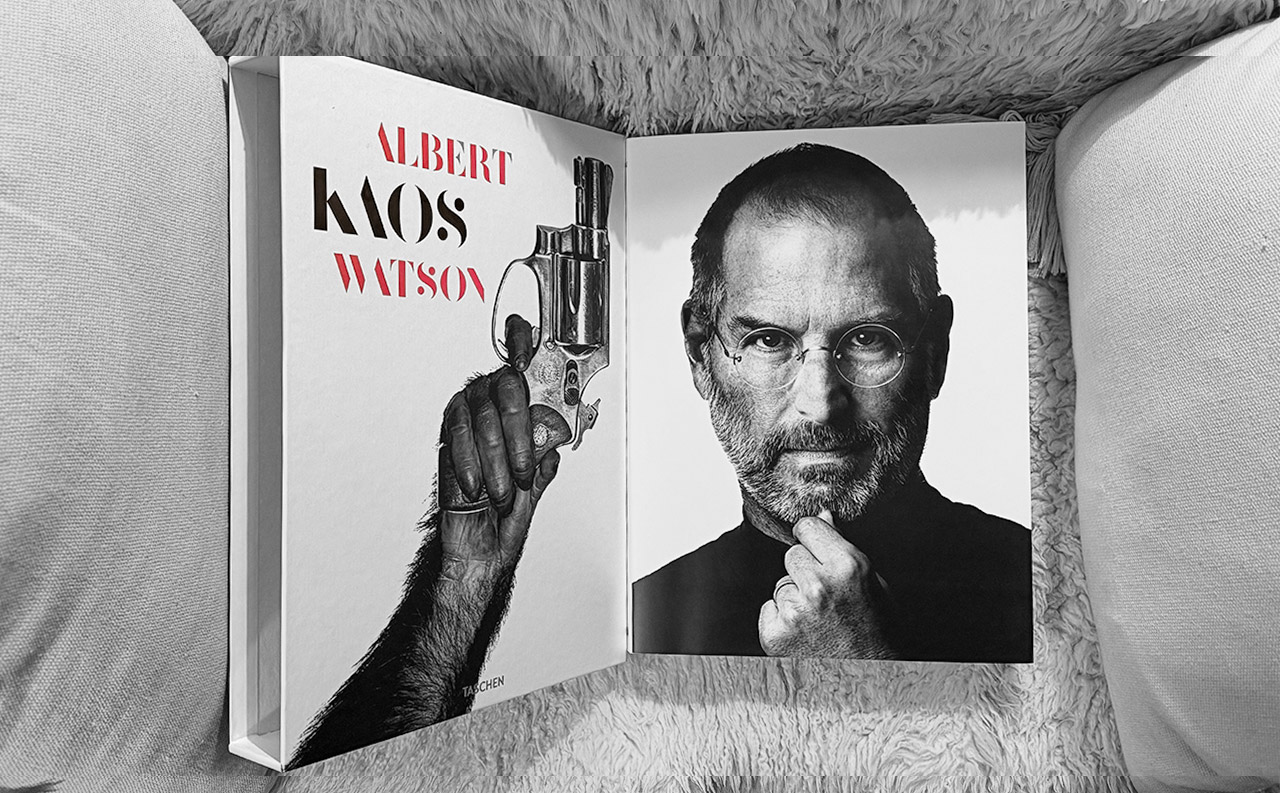

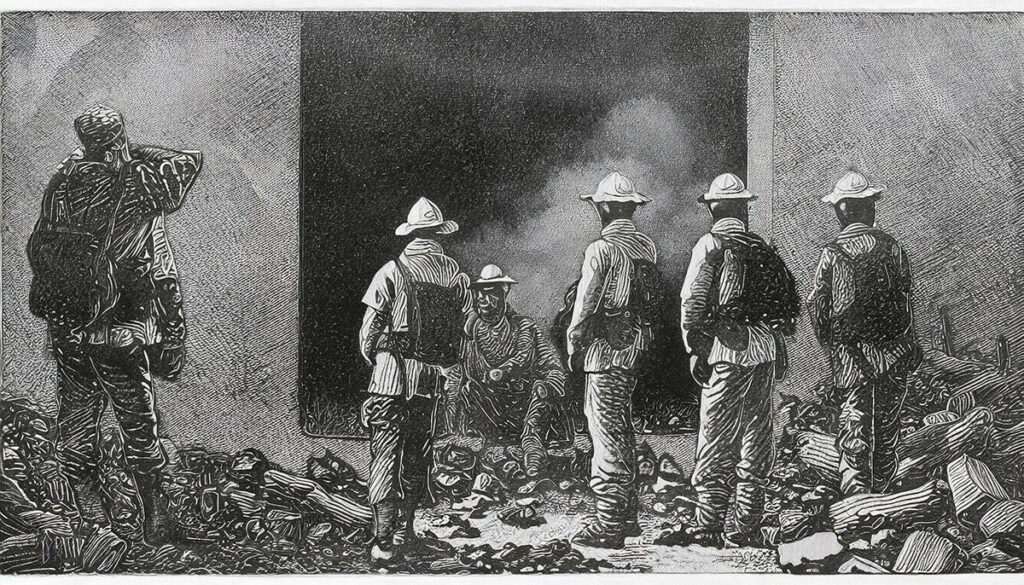

In Adobe Firefly können Sie nun nicht nur negative Prompts verwenden, sondern auch Bilder hochladen, an deren Stil sich die KI dann orientiert. Hier sind das ein Holzstich (oben) und ein Konturstich (unten) aus dem 19,. Jahrhundert. | Doc Baumann mit Firefly

Matt Smith unterscheidet hier klar zwischen einem irreführenden Gebrauch aufgrund der nahegelegten Annahme, es habe eine solche Szene wie die KI-generierte tatsächlich gegeben und das Bild sei ein Reportagefoto, und der Verwendung eines solchen Bildes als Illustration oder Symbolbild, die als solche deutlich zu erkennen sind. Kaum jemand erwartet, dass etwa ein Schlachtengemälde des Historismus in einem Museum das abgebildete Ereignis bis hin zu jedem Uniformknopf und Grashalm getreu wiedergibt. Nicht anders ist es bei montierten Bildern, 3D-Szenen oder nun KI-generierten; sie fassen die Gesamtheit einer Situation visuell zusammen – zumindest so, wie die Person es erwartet, die den Prompt formuliert hat.

(Analog wäre eine Richtlinie von Adobe sinnvoll, die strafbare Formen von Pornographie untersagt oder den Missbrauch solcher Bilder bei Verletzung von Persönlichkeitsrechten.)

Also: Entwarnung. Es geht um Irreführung mit KI-generierten Bildern, die etwa in Firefly erzeugt wurden, bei deren Einstellen in das Adobe Stock-Angebot. Und das ist voll zu unterstützen. Ebenso, wie Photoshop-Montagen bei entsprechender Verwendung nicht tolerierbar sind. Es geht ausdrücklich nicht darum, was man in dieser Hinsicht mit Firefly produzieren darf.

Übrigens sollte eine entsprechende Kennzeichnungspflicht von KI-Bildern in Bilddatenbanken noch aus ganz anderen Gründen gefordert werden: Sie zerstören nämlich langfristig gesehen das Modell der KI-basierten Bilderzeugung gleich auf doppelte Weise:

Zum einen gaukeln sie, als Trainingsmaterial für KI verwendet, dieser vor, sie seien genauso ein Abbild der realen Welt wie authentische Fotos. Je mehr KI-Bilder aber beim Training reinrutschen, um so weniger „weiß“ das System von der wirklichen Welt und mischt Fantasy, Science Fiction und Surreales munter mit echten Fotos, mit unabsehbaren Folgen. Da könnten dann schon mal Drachen und Elfen um die Ecke schauen.

Zum anderen werden aber neue KI-Bilder durch solches eingeschmuggelte Trainingsmaterial auch sichtbar und zunehmend schlechter, wie Forscher der Stanford und Rice Universität herausfanden: So finden sich etwa in Porträts störende Artefakte, welche Gesichter immer weniger menschlich aussehen lassen.

All das spricht dafür, bereits in der Datenstruktur Marker anzulegen, die vermeiden, dass KI-generierte Bilder ihrerseits für das KI-Training genutzt werden. Es ist darüber hinaus ja nichts daran auszusetzen, wenn KI-Bilder in Bilddatenbanken angeboten werden. (Obwohl deren urheberrechtliche Würdigung noch weitestgehend ungeklärt ist.) Aber es muss für die Käufer und Betrachter immer völlig klar und transparent sein, wie das jeweilige Bild zustande gekommen ist.

Illustration: Doc Baumann mit Firefly

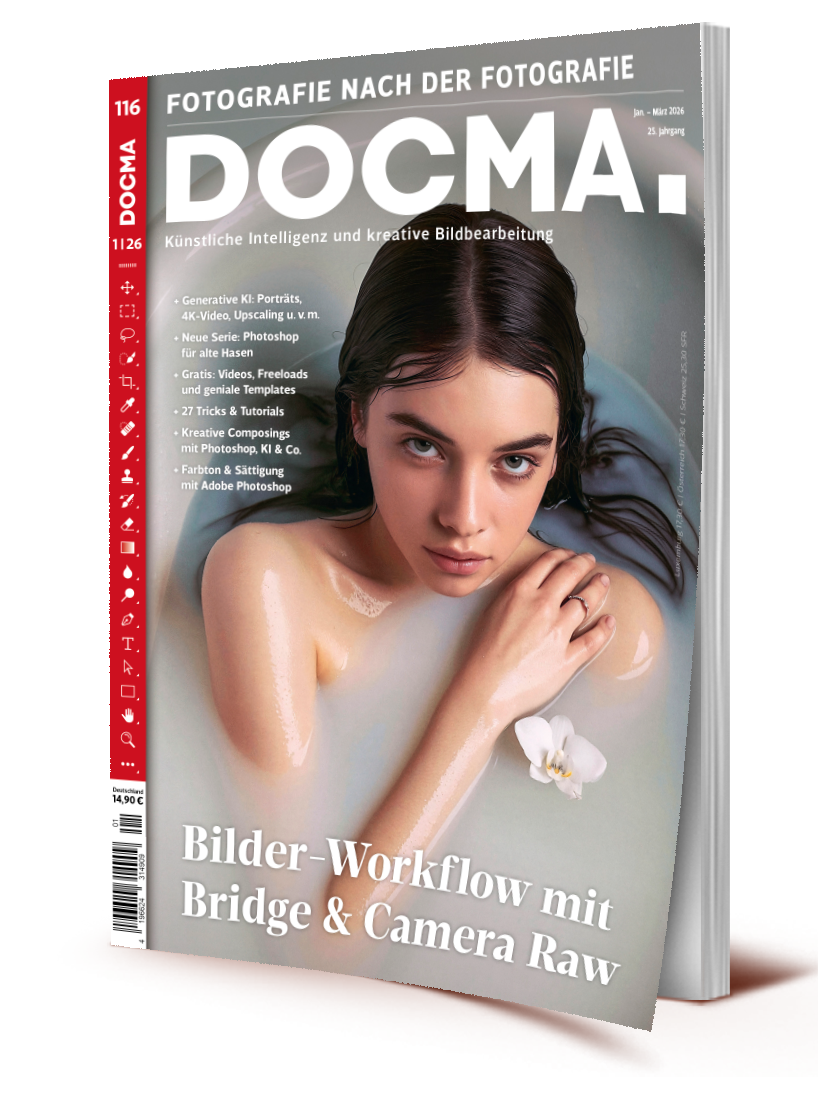

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft:

Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Das DOCMA-Magazin können Sie als Print-Ausgabe und als E-Paper kaufen oder abonnieren. Alternativ bieten wir die Inhalte der jeweils aktuellsten DOCMA-Ausgabe auch im Abo in Form der DOCMA2go als wöchentliche E-Mails an (verteilt über 13 Wochen).

Zu den Print-Abos | Zu den Digital-Abos