Beantworten Sie meine Frage!

Letzte Woche hatte ich an dieser Stelle darauf hingewiesen, dass redselige KI-Systeme wie ChatGPT und Bard eigentlich gar nicht dazu gedacht sind, Fragen zu verstehen und zu beantworten. Die Fachdisziplin der Künstlichen Intelligenz hat aber auch Frage-Antwort-Systeme für eben diesen Zweck hervorgebracht. Da das mal mein Spezialgebiet war, wird es heute etwas autobiografisch.

Die neueren, auf neuronalen Netzen basierenden Systeme, die derzeit nahezu gleich oft durch beeindruckende Leistungen wie durch haarsträubende Fehler auffallen, sind genau genommen nur auf eine einzige Aufgabe hin trainiert: unvollständige Texte fortzusetzen. Aus einem riesigen Korpus im Internet vorgefundener Text wurden die Übungsaufgaben extrahiert: Wenn ein Text so und so anfängt, wie geht er dann weiter? Um solche Aufgaben lösen zu können, mussten die neuronalen Netze lernen, zu verallgemeinern, und das gibt ihnen die Fähigkeit, auch solche Texte (meist) plausibel fortzusetzen, denen sie noch nie zu zuvor begegnet sind. Da eine Antwort auf eine Frage letztendlich auch nur eine Fortsetzung eines (dialogischen) Textes ist, können ChatGPT und Bard auch auf Fragen reagieren – nur gibt es keine Garantie dafür, dass diese Reaktion eine wahrheitsgemäße Antwort auf die Frage ist, schon weil das Verstehen von Fragen nicht zur Kompetenz solcher Systeme gehört.

Frage-Antwort- und Dialogsysteme waren insbesondere in den 70er und 80er Jahren des letzten Jahrhunderts ein wichtiges Teilgebiet der natürlichsprachlichen KI. Oft ging es um Datenbankabfragen, die auf Deutsch oder Englisch statt in einer Abfragesprache wie SQL erfolgen sollten, aber auch um Beratungsgespräche nach der Art heutiger Chatbots. Manche Forschungsgruppen beschäftigten sich mit Textverstehen, zum Beispiel der Interpretation von Zeitungsmeldungen, deren Inhalt ihre Systeme zusammenfassen oder wiederum Fragen dazu beantworten konnten. Die maschinelle Übersetzung war ein wichtiges Forschungsgebiet, und seltener konzentrierte man sich auf die Textgenerierung wie etwa der Aufgabe, Geschichten nach der Art von Tierfabeln zu erzählen.

In all diesen Forschungsprojekten ging es darum, Ausdrücke in natürlichen Sprachen syntaktisch und semantisch zu analysieren, um herauszufinden, was gemeint war. Erst danach erschien es sinnvoll, Aussagen in die Wissensbasis des Systems zu übernehmen – sofern sie nicht im Widerspruch dazu standen – oder Fragen auf Basis des vorhandenen Wissens zu beantworten. Wenn ein Satz nicht analysiert werden konnte, teilten die Systeme das mit, und ebenso, wenn die Beantwortung einer Frage außerhalb ihrer Kompetenz lag. Wenn sie aber eine Frage beantworteten, war die gegebene Antwort auch korrekt.

Wie gesagt, das war mal mein Spezialgebiet. Schon als ich mich 1978 zu Beginn meines Informatikstudiums für ein Nebenfach entscheiden musste, wählte ich spontan die Linguistik, nachdem mich ein Vortrag von Prof. Walther von Hahn fasziniert hatte – er hatte von seinem Projekt HAM-RPM (HAMburger RedePartner-Modell) erzählt, aus dem später das größere Drittmittelprojekt HAM-ANS wurde. Das System spielte die Rolle eines Hotelmanagers, der einem möglichen Gast Fragen zu einem freien Zimmer beantwortete. So etwas wie in diesem Projekt wollte ich auch machen!

Zuerst kam dann allerdings das Grundstudium. Während dieser Zeit schrieb mein Kommilitone Bernd Pretschner, der mir im Studium ein paar Jahre voraus war, eine Diplomarbeit, in deren Rahmen er ein Frage-Antwort-System namens SWYSS (Say What You See System) implementierte. Dessen Besonderheit war die Behandlung vager Quantifizierungen durch Wörter wie „einige“, „viele“, „wenige“ oder „die meisten“ – ein Spezialgebiet seines Betreuers Peter Schefe. SWYSS musste dazu die gestellten Fragen erst einmal syntaktisch analysieren, aber die dafür zuständige Komponente (ein sogenannter Parser) war eine improvisierte Quick&Dirty-Lösung – die syntaktische Analyse war ja nicht Teil der Diplomarbeit, so dass es nicht darauf ankam. Da sich dieser recht simplistische Parser aber nicht auf komplexere Satzkonstruktionen erweitern ließ, war mittelfristig ein neuer Parser nötig, weshalb der Betreuer und der Diplomand zusammen ein Projektseminar veranstalteten, um Studenten für diese Aufgabe zu interessieren.

Auf eine solche Gelegenheit hatte ich gewartet. Nachdem wir am Ende des Semesters eine erste Version des neuen, leistungsfähigeren Parsers und eines Entwicklungssystems für Grammatiken fertiggestellt hatten, verloren die meisten Seminarteilnehmer das Interesse, aber ich machte weiter, bis unser GESA (GrammatikEntwicklungs- und SyntaxAnalysesystem) einen finalen Status erreicht hatte und man ernsthaft damit arbeiten konnte. Daraufhin bekam ich den Auftrag, den alten Parser von SWYSS durch den neuen zu ersetzen, was allerdings, wie sich herausstellte, noch weitere Änderungen erforderte. Dabei erkannte ich, dass es nicht allzu schwierig war, SWYSS auch unvollständige (also elliptische) Fragen beantworten oder elliptische Antworten auf klärende Rückfragen verstehen zu lassen. Ich schrieb einen Artikel darüber („Ellipsenrekonstruktion im Kotext – Forderungen an eine Ellipsenkomponente und ihre Realisierung in SWYSS“), den ich zur alljährlichen deutschen KI-Fachtagung in Bad Honnef einreichte, und er wurde tatsächlich angenommen. Es war zwar keine besonders hochrangige (weil nur nationale) Tagung, aber der Artikel im Tagungsband war meine erste peer-reviewte wissenschaftliche Veröffentlichung. Den Tag meines Vortrags werde ich auch deshalb nie vergessen, weil nur wenige Stunden später Helmut Kohl im nahen Bonn per konstruktivem Misstrauensvotum zum Bundeskanzler gewählt wurde …

In meiner Diplomarbeit, die ich wiederum bei Peter Schefe schrieb, entwickelte ich dann völlig neue Versionen der Teile von SWYSS, die ich zunächst übernommen hatte, um die sprachlichen Phänomene zu erweitern, mit denen das System umgehen konnte. Unter anderem beschäftigte ich mich mit der Interpretation des Quantorenskopus: Wenn man behauptet, „Jeder Mann liebt eine Frau“, ist das dann so gemeint, dass es für jeden Mann irgendeine Frau gibt, die er liebt, oder eher so, dass es es eine bestimmte Frau gibt, die von jedem Mann geliebt wird? Die meisten damals existierenden natürlichsprachlichen Systeme ignorierten diese Ambiguität, und diejenigen, die – wie HAM-ANS – sie aufzulösen versuchen, nutzen eine Methode, die mir etwas hemdsärmelig und nicht wirklich gut begründet erschien, weshalb ich meinen eigenen, alternativen Ansatz entwickelte. Andere Themen waren Komparative und Superlative sowie Präsuppositionen und Präsumptionen, also Überzeugungen, die man einem Sprecher zuschreiben kann, wenn er eine Aussage macht oder eine Frage stellt. So setzt, um ein klassisches Beispiel von Bertrand Russell zu zitieren, „Der gegenwärtige König von Frankreich ist kahl“ voraus, dass es einen aktuellen König von Frankreich gibt, während „Schlagen Sie immer noch Ihre Frau?“ insinuiert, dass der Angesprochene zumindest früher einmal seine Frau geschlagen hat.

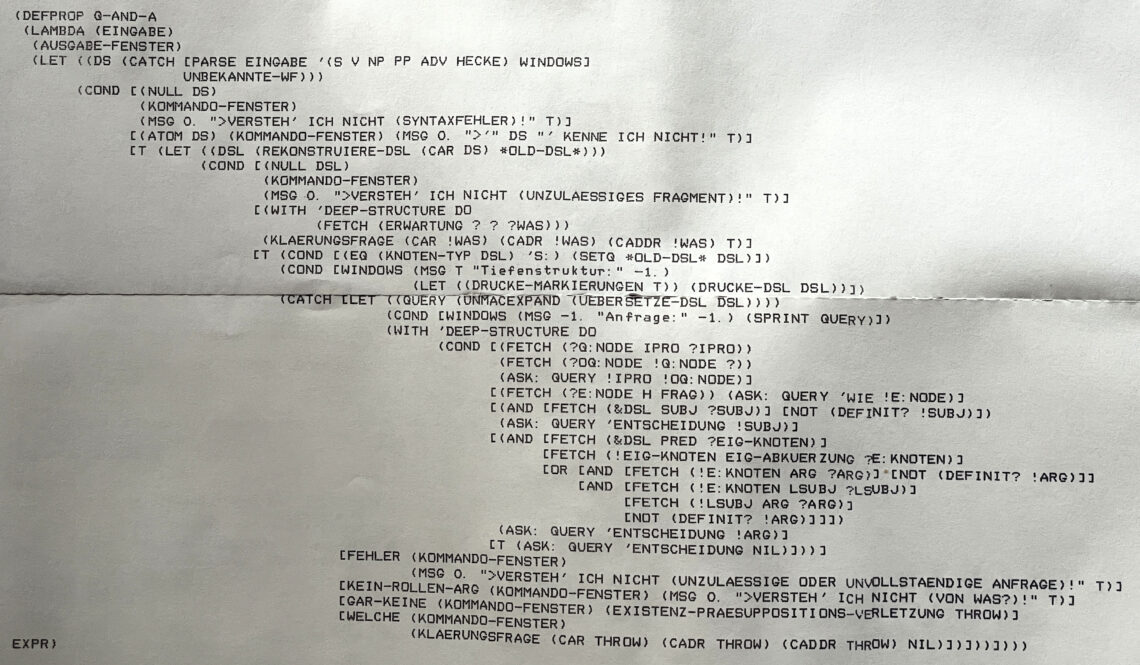

Am Ende – zwischendrin musste ich noch meinen Zivildienst ableisten – hatte ich zwar mein Diplom, aber erneut verschiedene unverbundene Komponenten und kein vollständiges System. Eine Diplomarbeit reicht ja selten für ein ganzes KI-System, sondern beschränkt sich meist auf die Entwicklung einzelner Teile, und in meinem Fall war das die Übersetzung einer bereits syntaktisch und semantisch analysierten Repräsentation der Eingabe in Ausdrücke einer selbstentwickelten Abfragesprache sowie deren Auswertung. Dass dann doch noch ein komplettes SWYSS 2.0 daraus entstand, kam so: Prof. Peter Schefe, zu diesem Zeitpunkt mein Chef, weil ich inzwischen eine Stelle als wissenschaftlicher Mitarbeiter hatte, bekam einen Anruf eines WDR-Redakteurs. Der WDR wollte einen Beitrag über natürlichsprachliche Systeme produzieren und ihn dazu interviewen, wozu auch auch die Vorführung eines solchen Systems gehören sollte. Damit hatten wir ein Problem, denn SWYSS 1.0 war alter Kram, den wir eigentlich nicht noch einmal zeigen wollten, und SWYSS 2.0 bloß ein paar unverbundene Komponenten mit einigen Lücken. Immerhin wollte das Filmteam des WDR erst zwei Wochen später aus Köln anreisen, und was tut man nicht alles für ein paar Sekunden Ruhm im Fernsehen … Nach zwei Wochen intensiver Entwicklungsarbeit und wenig Schlaf hatte ich ein vorführbares System am Start, das sich tatsächlich durchaus sehen lassen konnte:

MJH: Wer ist der Leiter des LOKI-Projekts? SWYSS: WALTHER VON HAHN MJH: Wer ist der Förderer von dem Projekt des Professors? SWYSS: WELCHEN PROFESSOR MEINST DU – ICH KENNE 5: PETER SCHEFE, BERND NEUMANN, WALTHER VON HAHN, CHRISTOPHER HABEL und WOLFGANG WAHLSTER? MJH: Bernd Neumann SWYSS: WELCHES PROJEKT MEINST DU – ICH KENNE 3: NAOS, WISBER und TEX-K? MJH: NAOS SWYSS: DEUTSCHE FORSCHUNGSGEMEINSCHAFT. MJH: Von wem wird das Projekt MARVIN geleitet? SWYSS: PETER SCHEFE. MJH: Und gefördert? SWYSS: WEISS ICH NICHT. MJH: Arbeiten Andreas und Roman in einem Projekt, das von Professor Neumann geleitet wird? SWYSS: JA. MJH: In welchem Projekt? SWYSS: TEX-K. MJH: WISBER hat doch nicht nur vier Verbundpartner? SWYSS: Doch, 4: SCS ORGANISATIONSBERATUNG UND INFORMATIONSTECHNIK, SIEMENS AG, NIXDORF COMPUTER AG und UNIVERSITAET DES SAARLANDES. MJH: In welchem Projekt arbeitet Frau Busche? SWYSS: WISBER. MJH: Und bei welchem Unternehmen? SWYSS: SCS ORGANISATIONSBERATUNG UND INFORMATIONSTECHNIK

In den folgenden Jahren habe ich mich dann noch mit anderen Aspekten natürlichsprachlicher Systeme beschäftigt, unter anderem mit dem Tempussystem des Deutschen, erneut auch dem syntaktischen Parsing, und entwickelte zuletzt einen Ansatz zur Interpretation von Sprechakten, also was Äußerungen über die Überzeugungen und Absichten des Sprechers verraten, und damit, wie Menschen mit dem Mittel der Sprache kooperieren. In meiner letzten wissenschaftlichen Veröffentlichung, bevor ich dann einen ganz anderen beruflichen Weg einschlug, einem Beitrag zur internationalen Computerlinguistik-Konferenz COLING 1990, ging es um diese Thematik („On Trying to Do Things with Words“, mit Heinz Genzmann).

Bei den natürlichsprachlichen KI-Projekten jener Zeit stand der Wunsch im Vordergrund, besser zu verstehen, wie wir Sprache benutzen. Schon in simplen Sätzen verbergen sich bei genauerer Analyse etliche Phänomene, die analysiert und verstanden werden wollten, und wir waren erst zufrieden, wenn es uns gelungen war, den Computer dasselbe erkennen zu lassen, was für den Menschen offensichtlich war.

Wenn die damaligen Systeme aber schon vor rund 40 Jahren selbst sprachliche Feinheiten verstehen und Fragen zuverlässig beantworten konnten, warum erregten sie nicht so viel Aufsehen wie ChatGPT heute? Warum führte unsere Arbeit zwar zu sprachwissenschaftlichen Erkenntnissen, aber nicht zu praktisch einsetzbaren Anwendungen?

Fast die gesamte KI-Forschung beschränkte sich damals auf Mikrowelten – kleine, abgeschlossene Gegenstandsbereiche, in denen unsere Systeme funktionierten. Sobald man die Grenzen dieser Bereiche überschritt, versagten sie, und eine Skalierung scheiterte; der Aufwand wäre unüberschaubar groß geworden. Eben hierin brillieren nun aber die neueren KI-Systeme auf Basis neuronaler Netze, die sich mit riesigen Korpora aus allen möglichen, nicht unbedingt zusammenhängenden Bereichen trainieren lassen. ChatGPT kann nicht nur zu allen denkbaren natur- und geisteswissenschaftlichen Fachfragen etwas sagen, das nicht auf den ersten Blick absurd erscheint, sondern kennt auch noch jeden Promi-Klatsch und hat eine Haltung zu Kinofilmen, Popmusik oder populären Romanen. Die neuronalen Netze lassen es zwar an der Tiefe ihres Verstehens mangeln, aber die Breite ihrer Abdeckung aller Themenbereiche ist phänomenal.

KI-Systeme, die mehr als vermeintlich allwissende Blender sind, sondern tatsächlich Zusammenhänge erkennen können, müssten die Eigenschaften der symbolischen KI-Systeme der 70er und 80er Jahre mit denen der aktuellen Systeme auf Basis neuronaler Netze kombinieren, was bislang kaum möglich erscheint; die Ansätze sind einfach zu verschieden. So etwas wäre allerdings nötig, wenn die Künstliche Intelligenz ihre noch immer prinzipbedingten Einschränkungen überwinden soll, denn auch die neuen Systeme unterliegen Beschränkungen, die lediglich anderer Art als früher sind.

Aber wer weiß: Vielleicht ist es besser so, wenn das nicht geschieht.