Keine Angst vor kleinen (Sensor-) Pixeln!

Die Lebenserfahrung des Fotografen besagt, dass niedrige Sensorauflösungen kleine Unschärfen kaschieren. Daher liegt die Befürchtung nahe, dass umgekehrt immer höhere Megapixelzahlen nicht nur mögliche Schwächen vorhandener Objektive aufdecken, sondern auch die unvermeidliche Beugungsunschärfe zu einem ernsten Problem machen würden. Doch diese Sorge ist unbegründet.

Viele von uns haben es in den vergangenen Jahrzehnten selbst erlebt: Digitalkameras mit immer höheren Auflösungen machten offensichtlich, dass bewährte Objektive aus der analogen Ära doch nicht so scharf zeichneten, wie man früher geglaubt hatte. Und die Pixelzahlen steigen ja immer weiter; im Kleinbildformat sind 60 und im APS-C-Format 40 Megapixel der Stand der Technik, und schon im kleinen Mittelformat (44 × 33 mm) werden 100 Megapixel erreicht. Darf man bei solchen Auflösungen überhaupt noch abblenden, oder macht die Beugungsunschärfe dann das Auflösungsvermögen des Sensors zunichte?

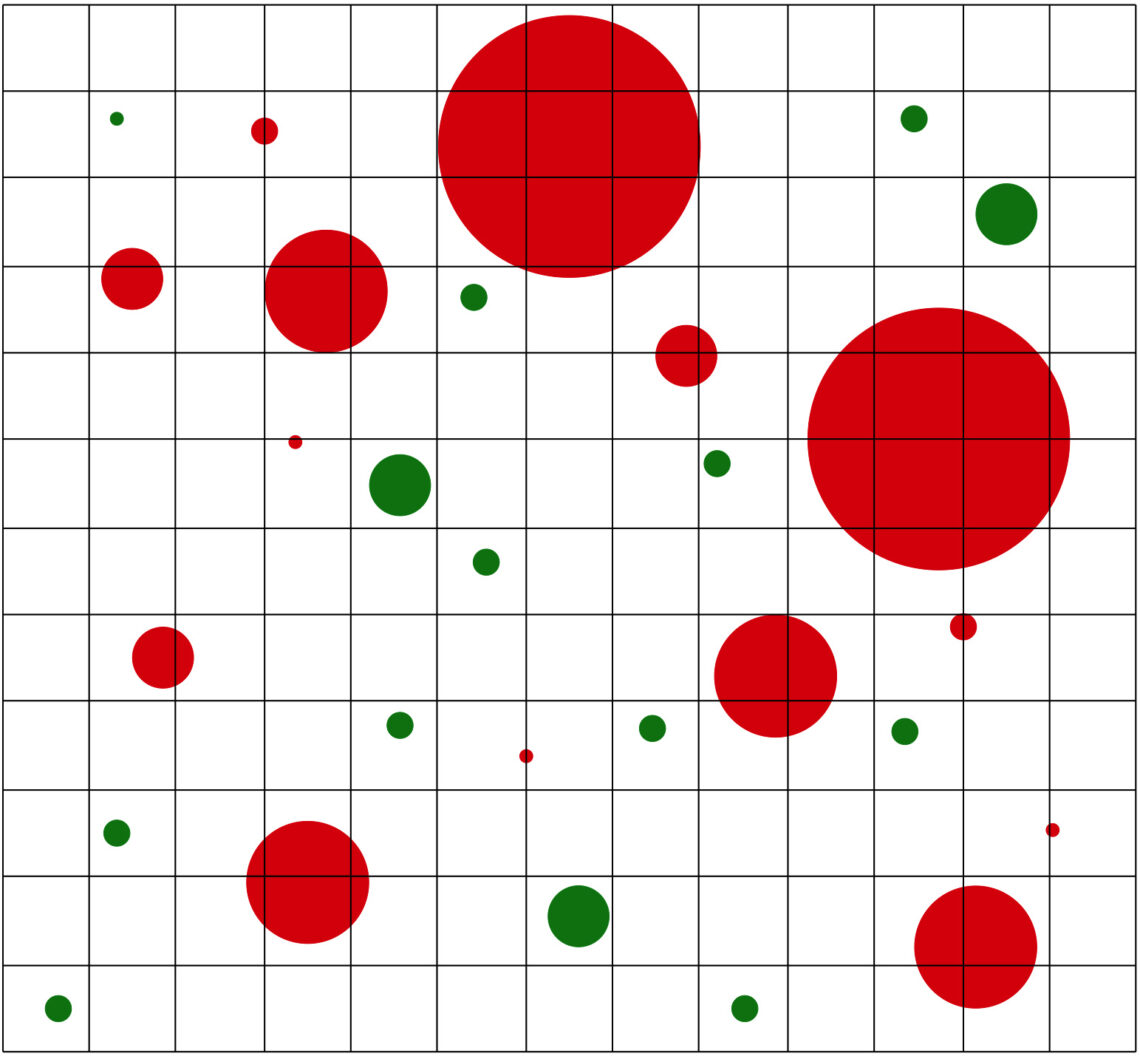

Könnte ein Objektiv vollständig scharfe Bilder erzeugen, würde es jeden Punkt der fotografierten Szene in einen Punkt auf dem Sensor abbilden. Dieses Bild würde dann in ein feineres oder gröberes Raster von Pixeln zerlegt, so dass allein das Pixelraster die Auflösung begrenzt.

In der Praxis ist die Abbildung eines Punktes aus verschiedenen Gründen oft kein Punkt, sondern ein mehr oder minder scharf begrenztes Scheibchen – ein Unschärfekreis, wenn der Punkt nicht fokussiert ist, ein Beugungsscheibchen aufgrund der Beugung an der Blende, ein wolkiges Gebilde aufgrund der sphärischen Aberration und so weiter, wobei sich alle diese Unschärfen addieren. Sofern ein solches Scheibchen vollständig in die Fläche eines einzelnen Sensorpixels passt, fällt nicht auf, dass es kein Punkt ist, aber wenn es zwei oder mehr Sensorpixel belichtet, sinkt der Kontrast zwischen diesen Pixeln und das Bild erscheint an dieser Stelle unscharf. Scheibchen, deren Durchmesser größer als das Pixelraster ist, müssen naturgemäß stets Unschärfe erzeugen; bei kleineren Scheibchen hängt es von ihrer Lage im Pixelraster ab. Jedes Bild besteht aus unzähligen solcher Scheibchen, und je gröber das Pixelraster ist, desto mehr von ihnen belichten nur ein einziges Pixel, womit die Unschärfe kaschiert wird.

Bei einem höher auflösenden Sensor mit entsprechend kleineren Pixeln gibt es daher mehr sichtbare Unschärfe – zumindest wenn man sich einzelne Pixel anschaut. Das optische Bild ist aber unabhängig von der Sensorauflösung immer dasselbe, und ein Sensor mit mehr Megapixeln rastert es lediglich feiner auf. Das Ergebnis ist eine Überabtastung (Oversampling), wie man sie aus dem Audiobereich kennt: Wenn Musik mit einer höheren Frequenz gesampelt wird, als es für die höchste von menschlichen Ohren hörbaren Töne nötig wäre, wird das wahrnehmbare Tonspektrum zwar nicht erweitert, aber die hörbaren Töne werden nach der Rückverwandlung der digitalen Daten in analoge Audiosignale sauberer wiedergegeben. In der Digitalfotografie ist es ähnlich: Mit einer höheren Sensorauflösung wird das optische Bild feiner abgetastet und damit ebenfalls sauberer wiedergegeben.

An der Unschärfe in einem Bild ändert das nichts. Ein feiner abgetastetes Bild zeigt nicht weniger Details, nur weil seine so oder so vorhandene Unschärfe sichtbarer wird, sofern man es in einer 100-Prozent-Ansicht betrachtet. Vergleicht man zwei Versionen eines Bildes mit unterschiedlicher Pixelzahl als Prints gleicher Größe, dann kann das niedriger aufgelöste Bild keine Vorteile für sich geltend machen.

Nehmen wir an, wir betrachteten einen großformatigen Print in einer Fotoausstellung, und aus der Nähe erschiene uns das Foto nicht ganz scharf – übrigens eine gar nicht so seltene Erfahrung, wenn man berühmte Bilder der Fotogeschichte zum ersten Mal in einem großen Format sieht. Also treten wir ein paar Schritte zurück, bis wir die Unschärfe nicht mehr bemerken – die begrenzte Auflösung unserer Augen sorgt für einen ähnlichen Effekt wie eine niedrigere Sensorauflösung. Das funktioniert mit der Beugungsunschärfe ebenso wie mit allen anderen Arten der Unschärfe.

Würde man dasselbe Foto mit einer Kamera mit geringerer Pixelzahl aufnehmen, dann könnte es sein, dass die Beugungsscheibchen deutlich kleiner als die nun entsprechend größeren Pixel sind und daher nur eine kaum noch wahrnehmbare Unschärfe erzeugen. Aber was wäre damit gewonnen? Träte man wieder näher an das Bild heran, würde zwar keine störende Beugungsunschärfe mehr sichtbar, aber dafür ein hässliches Pixelraster. Wir hätten die Beugungsunschärfe gegen eine noch gröbere Verpixelung eingetauscht, und was nützen Pixel mit knackscharfen Mikrokontrasten, wenn doch als solche erkennbaren Pixel gerade vermieden werden sollten?

Hinzu kommt, dass man wohlbekannte Arten der Unschärfe, wozu neben der Beugungsunschärfe auch die durch Abbildungsfehler wie die sphärische Aberration verursachte Unschärfe zählt, mit einem Dekonvolutionsverfahren teilweise herausrechnen kann. Fuji-Kameras verwenden dazu schon seit Jahren einen Lens Modulation Optimizer (LMO), und anderer Kamerahersteller haben mittlerweile nachgezogen. Eine solche Dekonvolution funktioniert um so besser – und erzeugt um so weniger Artefakte –, je größer die Megapixelzahl und je feiner daher das optische Bild aufgerastert ist. Auch eine Nachschärfung mit KI-Methoden profitiert von mehr Megapixeln.

Entgegen der Intuition hindert uns ein höher auflösender Sensor also nicht daran, weiter abzublenden, wenn die gewünschte Schärfentiefe das nahelegte. Das Bild wird keinen Deut unschärfer als bei Verwendung einer weniger hoch auflösenden Kamera, sondern lediglich feiner abgetastet, und es bietet damit bessere Voraussetzungen für alle weiteren Verarbeitungsschritte. Selbst wenn wir das Bild am Ende auf eine niedrigere Auflösung herunter skalieren, wird es danach deutlich sauberere Details zeigen, als wenn wir es von vornherein mit einem Sensor dieser Auflösung aufgenommen hätten.